Google I/O 2025の基調講演は、予想通りAI一色でした。基調講演でのAIの存在感は数年前から増していましたが、今年は特に「AIエージェント」が占める割合が増え、次の段階に来てる感がありました。

今回の「Google Tales」では、Google検索が生成AIでどう変わっていくのかを考えます。「AI Overview」(日本では「AIによる概要」)から「AI Mode」へ、そしてAIが変えるショッピング体験、未来の「AIエージェント」がどうなっていくのか、などをつらつらと。

「AIによる概要」から「AI Mode」へ

従来のGoogle検索の基本は、ユーザーが知りたいことを単語や短いフレーズで入力し、何ページにもわたって表示される多数のリンク先(昔は青かったやつ)の中から目的の情報が載っていそうなものをクリックするというものでした。このモデルは長年、Web上の情報への「入り口」として機能してきました。

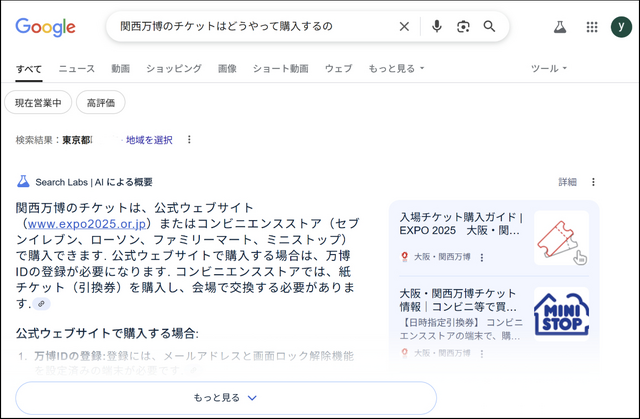

クエリの誤入力確認(もしかして○○?、というやつ)やランクブレインなど、機械学習はかなり前からGoogle検索に導入されていましたが、I/O 2023で発表された「SGE(Search Generative Experience)」、I/O 2024に発表されたその進化形である「AIによる概要」はいわゆる生成AIで、それまでのAIとは違うのでした。日本でも2024年8月から、一部の検索結果のトップに「AIによる概要」が表示されるようになっています。

▲検索結果のトップに「AIによる概要」が表示される例

「AIによる概要」は、文字通りユーザーの知りたいことをAIが要約して表示する機能です。当初は、ピザのチーズは接着剤でつけるのがオススメ、などの誤った情報を提供して信頼性の低さを揶揄されたこともありましたが、その後、少しずつ良くなってきている印象です。

Google自身はこの機能を「複雑なトピックや質問の要点を掴むのに役立ち、さらに学ぶためのリンクを提供するもの」と説明しています。つまり、検索ページ内で情報を完結させるのではなく、信頼できる情報源への「入り口」を提供する役割だと強調しています。

Googleのスンダー・ピチャイCEOは、「AIによる概要」が表示される場合でも広告収益は維持されており、情報源へのリンクをクリックしたユーザーの、情報源サイトでの滞在時間も長くなっていると述べています。

Googleによると、「AIによる概要」の導入後、人々はGoogle検索に対してより複雑で、長く、マルチモーダルな質問をするようになったそうです。「AIによる概要」がAIの可能性を示したことで、ユーザーの検索に対する期待値が上がり、より高度な検索体験を求めるようになった結果だとGoogleはみているそうです。このユーザー行動の変化が、次世代の検索体験「AI Mode」の開発を後押ししました。

AI Modeがやってくる

Google I/O 2025の基調講演で最も注目された機能の一つがAI Modeです。3月から一部でのテストは始まっていましたが、基調講演の日から米国で提供が開始されました。

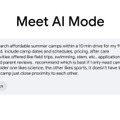

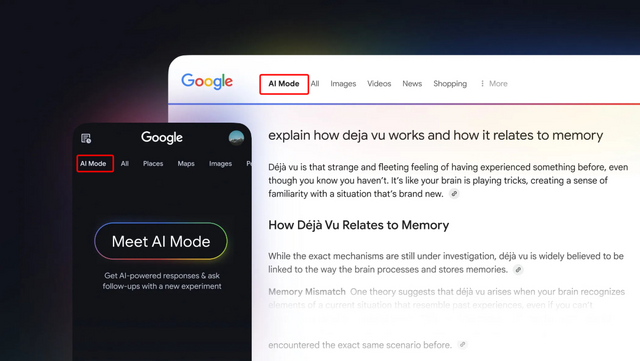

▲基調講演の主役、AI Mode

AI Modeは、「画像」「動画」「ニュース」といった従来の検索タブと並んで、新しいタブとして先頭(左端)に追加されます。AIが検索体験の選択肢の一つとして明確に位置づけられたとみていいでしょう。

▲米国では既に提供されている「AI Mode」のタブ

GoogleはAI Modeを「AIを活用した、まったく新しい検索体験」と説明しており、既に利用している米国のユーザーのレビューを見ると、GoogleのGeminiアプリやOpenAIのChatGPTアプリが検索ページに直接組み込まれたような使用感だと評価されています。

Googleはずっと、生成AIの検索への直接統合に慎重な姿勢を示してきましたが、さすがにChatGPTのような競合の台頭に対処しないわけにはいかなかったんだろうと思います。

▲ChatGPTで「検索」をオンにすると、ユーザーが設定した地域でリアルタイムでよく検索されているクエリが表示されます。昔ならググってたような内容ですね

従来の検索が「リンク集への入り口」であったのに対し、AI Modeは「対話型アシスタント」として、検索結果内で直接、複雑な質問への回答を生成します。これは、検索の価値を「情報発見」から「知識生成と問題解決」へと拡大するものです。基調講演やその後の公式ブログでは「Beyond information to intelligence」というフレーズが何度も出てきました。Google検索は単なる情報提供から深い理解に基づく分析と支援へと進化する、という意味です。

▲検索は単なる情報提供から深い理解に基づく分析と支援へ

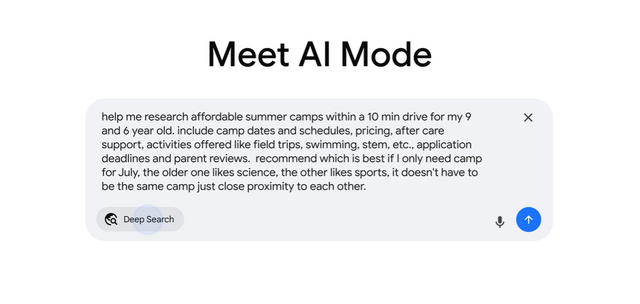

AI Modeは、ユーザーの複雑な質問に対し、対話や画像やグラフまで交えて、その場で回答します。長い文章の質問に対しても、項目別に整理された回答を生成し、その根拠となる情報源を右側に並べて表示します(でも情報源に飛ばなくてすむ程度のまとめになるので、情報の信頼性を確認するためのリンク、という感じです)。

さらに、AI Modeはフォローアップ質問に対応していて、ユーザーは最初の回答を深掘りしたり、視点を変えて質問を続けたりできます。AI Modeの基盤にはGoogleのGeminiモデルが活用されており、Geminiの推論能力とマルチモーダル入力(テキスト、画像、音声)がそのまま検索でも使えます。

▲AI Modeの使い方を紹介するちょっとわかりにくい動画

AI Modeの特徴は、「クエリファンアウト技術」を採用していることです。これは、ユーザーの質問を複数のサブトピックに分解し、同時に多数のクエリを発行することで、従来の検索では到達できなかったWebの深部まで探索することを可能にするというものです。(fan-outのファンは扇で、つまり扇のように広げていく感じですね。)

▲fan-outの説明図。扇の骨1本ずつの先っぽからさらに扇が広がっていくイメージです。

こうした新機能やクエリファンアウト技術をさらに進化させた「Deep Search」が、検索を「情報探し」から「知識生成」へと進化させるんだとGoogleは説明しています。ユーザーはもう、複数のキーワードを試したり、多数のリンクをいちいちクリックしたりしなくても、AIが複雑な情報収集と合成の認知労働を肩代わりしてくれるのだそうです。

▲「Deep Search」。「Deep Research」とはまた別。まぎらわしいなぁ

AI Modeは、ユーザーが許せばパーソナライズされた提案をするようになります。ユーザーの過去の検索履歴に基づいてカスタマイズされた結果を提供し、将来的にはGmailなどの他のGoogleアプリと連携することで、個人のコンテキスト(過去の予約や旅行計画など)を取り込み、いちいち説明しなくても自分に関連性の高い提案をしてくれるようになるそうです。また、複雑なデータセットを分析し、カスタムのグラフやチャートを作成する機能も搭載しています。例えば、異なる野球チームのホームフィールドアドバンテージを比較するといった、データに基づいた洞察を視覚的に提供できるようです。

マルチモーダル入力とパーソナライゼーションの強化は、検索体験を「人間中心」へと進化させるとGoogleは語っています。検索が単なる情報検索ツールから、個人の「デジタルアシスタント」になりつつあると。

AI Modeでお買い物に突入

Google I/Oの基調講演では、AI Modeでの商品発見からバーチャル試着、商品購入までのデモも話題になりました。これらはまだ実験段階ですが「今後数カ月以内に展開する予定」だそうです。

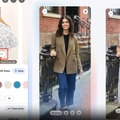

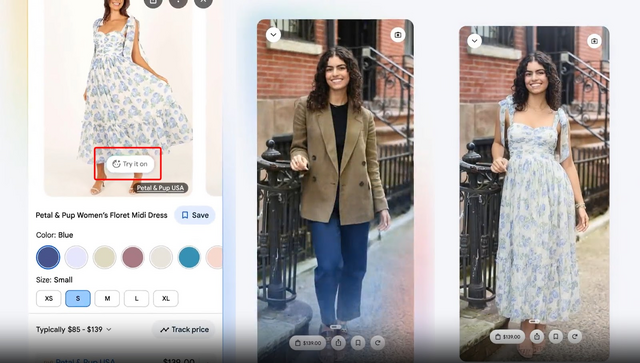

バーチャル試着

例えばAI Modeで「サマードレス」を検索すると、単なるドレスの画像一覧ではなく、考慮すべき特徴やトップオプションの比較、信頼できるレビューや購入ページへのリンクを提供します。

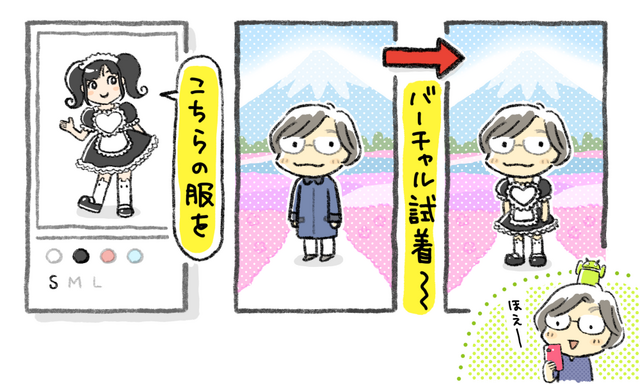

候補の中から気になるドレスを選んで、そこに「Try it on(試着してみる)」ボタンが表示されていたら、バーチャル試着できます。ボタンをクリックして自分自身の全身写真をアップロードすると、写真の中の自分がドレスに着替えるのです。少なくとも基調講演のデモでは、ちゃんと試着してる感じになってました。

▲バーチャル試着

バーチャル試着には、Googleがファッション向けに特別にトレーニングしたカスタム画像モデルを使っていて、このモデルは詳細な3D形状を保持できるので、服の素材で生じるシワや伸縮具合を保ちつつ、全体のシルエットをユーザーの写真から生成した3D画像に着せてみせられるんだそうです。

これまで、紙のカタログでもオンラインショップでも、「いいな」と思って買った服を実際に着てみたら「おや?」となることは結構ありました。バーチャル試着の精度が高ければ、購入が増え、返品率は下がるでしょう。そうすれば、オンラインショップにとってもメリットは大きそうです。とはいえ、商品を検索結果に表示させ、「試着ボタン」も表示させるには、ブランドやオンラインショップ側は、これまで以上に正確なデータや詳しい製品説明などを用意する必要がありそうです。

エージェント型チェックアウト

試着してこれを買おうと決めたら、今度は「エージェント型チェックアウト」に購入を任せられるようになります。ユーザーが設定した条件に基づいて製品価格を追跡し、条件に合致したお得な取引があったらアラートで知らせてくれます。さらに、Google Payを通じて自動的にチェックアウトを完了させることも可能です。

Googleは、エージェント型チェックアウトを、AIが単なる情報提供者から「実行者」へと役割を拡大していることを示すものだとしています。

ユーザーにとっては便利そうですが、ブランドやショップ側はAIによる価格追跡やプロモーション戦略への適応が大変そう。つらい値下げ合戦になったりしないといいんですが。

Google検索上のAIエージェント

エージェント型チェックアウトは、GoogleがChrome向けエージェントとして取り組んでいる「Project Marinar」の能力をAI Modeに統合することで実現する予定です。

Googleは、AIエージェントはボットやAIアシスタントとは明確に違うとしています。

ボット: 事前定義されたルールに従って動作し、学習能力は限定的。基本的な対話や単純なタスクの自動化を行う。ユーザーのトリガーやコマンドに反応する。

AIアシスタント: ユーザーの要求やプロンプトに応答し、情報を提供したり、簡単なタスクを完了させたりする。アクションを推奨することはできるが、最終的な意思決定はユーザーが行う。ユーザーに対して受動的。

AIエージェント: 自律的で能動的にタスクを実行することを目的としている。複雑な多段階のアクションを実行し、経験から学習・適応し、独立して意思決定できる。ユーザーに対して能動的で、目標達成志向。

AIエージェントは、単なる情報提供やアシストを超え、ユーザーの意図を理解し、自律的に行動し、学習し、意思決定する「能動的なパートナー」であるという点で、検索の未来を象徴しているとGoogleは説明します。これは、検索が「質問への回答」から「タスクの完了」へと進化する、より大きなトレンドの一部であり、ユーザーがAIに複雑な作業を委任できる時代の到来を示唆している、と。

AI ModeのAIエージェントは「自律的なバックグラウンドプロセス」で、舞台裏で動作し、ルーチンタスクの自動化、データ分析による洞察の提供、プロセスの最適化、潜在的な問題の能動的な特定と対処を行います。

例えば、チケットの検索や予約といった多段階のタスクを実行します。自律的ではあっても、勝手に行動するのではなく、主導権はユーザーにあるとGoogleは強調しています。

Google検索へのAIエージェントの統合は、検索が単なる情報検索ツールから、ユーザーの「デジタル生活のオーケストレーター」へと進化する究極の形なんだそうです。

全部無料で使えるけど、Googleは大丈夫?

AI Modeは日本では「AIモード」になりそうです。

▲まだ使えません画面に「AIモード」と

日本でいつから使えるようになるのかまだ発表がありませんが、早く使ってみたいです。特にバーチャル試着。自分の写真をアップロードするのにはちょっと抵抗ありますが、久しぶりに好奇心がプライバシー意識を上回る案件です。

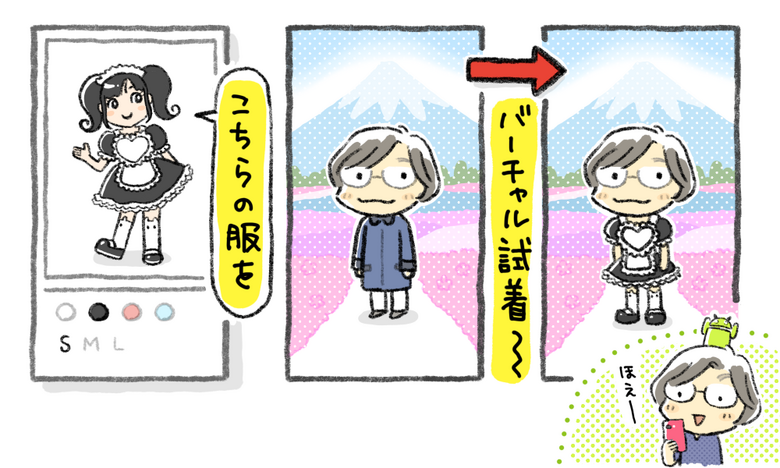

▲リアルでは試着できそうになくても……(イラスト:ばじぃ)

こんなに便利なものが無料で使えるなんてすごいですよね。

Googleの主な収入源は、検索結果に表示される広告(Google広告)と提携サイトに表示する広告(Google AdSense)で、これを担当する「Google Search and other」部門がAlphabetの総売上高に占める割合は、直近の業績発表で約56%でした。

これまで、ユーザーが入力するクエリやGmailなどのデータを使って広告表示精度を上げるといういいバランスでユーザーは無料で(というか個人データを代償にしてるわけですが)サービスを使えてきました。

でも、AI Modeがとても便利になって、ユーザーが広告や情報源のリンク先をクリックしなくなったら、このバランスは崩れてしまいそうです。

また、世界各国でふつふつしている独禁法やプライバシー保護関連の規制も心配です。Chromeを売却しろというのが実現するだけでもバランスは崩れるでしょう。

いろいろ心配事はありますが、個人的にはGoogleさんにはこのままぐいぐい先に進んでほしいところです。