1週間の気になる生成AI技術・研究をいくつかピックアップして解説する連載「生成AIウィークリー」から、特に興味深いAI技術や研究にスポットライトを当てる生成AIクローズアップ。

今回は、夢を脳波(EEG)信号で解読し、AIを用いて画像化するためのデータセット「Dream2Image」を提案した論文「Dream2Image : An Open Multimodal EEG Dataset for Decoding and Visualizing Dreams with Artificial Intelligence」を取り上げます。カリフォルニア大学サンディエゴ校に所属する研究者による発表です。

▲AIが夢を画像に変換してスマホに表示しているイラスト(絵:おね)

Dream2Imageデータセットは、38名の参加者から収集された31時間以上の夢のEEG記録に基づいており、129個の夢サンプルが含まれています。各サンプルには、覚醒前の最後の15秒、30秒、60秒、最大120秒の脳活動記録、夢体験の報告、そして夢の近似的な視覚的再構成(AI生成画像)が含まれています。

参加者は18歳から35歳(平均20.7歳)で、56%が男性、44%が女性でした。睡眠障害や精神疾患の既往歴がなく、睡眠に影響を与える薬物を服用していないなどの基準を満たしていました。

EEG信号は、Neuroscan SynAmpsシステムとBrainProducts HD-EEGシステムの2つのシステムで収集され、データの調和のために17個の共通電極が保持されました。

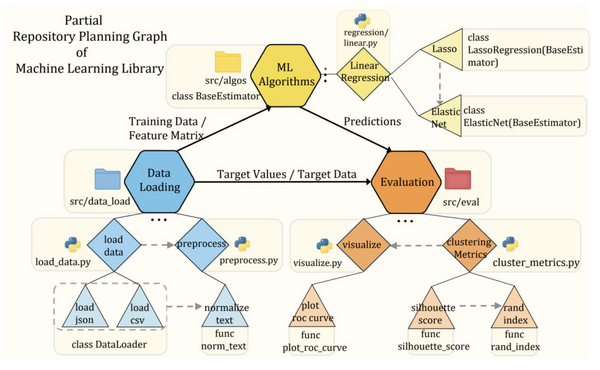

画像生成プロセスは複数の段階から構成されています。まず、夢の重要な要素(感情的なニュアンス、文脈、色彩、人物など)を特定する意味抽出が行われます。次に、画像生成モデル用のプロンプトが作成され、AIエージェントによる神経心理学的な検証と調整が行われます。

その後、DALL-E 3モデルを使用して画像が生成され、生成された画像と元の夢の記述との忠実度が評価されます。忠実度スコアが最小閾値を満たすまで、このプロセスは繰り返されます。

こちらのデータセットはHugging Faceで公開されています。

▲参加者の夢をAIが多段階プロセスを経て視覚化した画像例