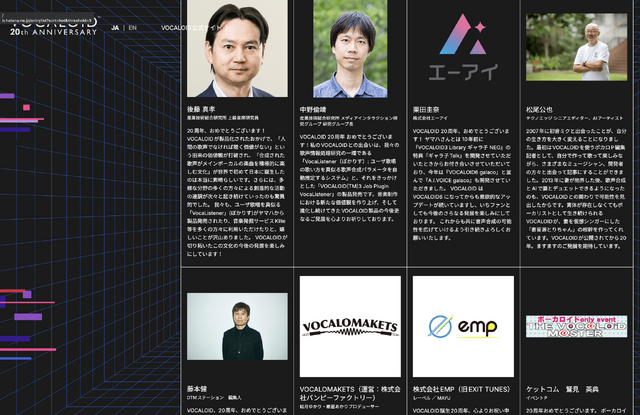

VOCALOIDが発売から20年を迎え、ヤマハの特設ページ「VOCALOID 20th Anniversary.」が公開されました。

継続的にVOCALOIDの新技術を取材し試して記事にしていた筆者もお祝いのメッセージを書きました。

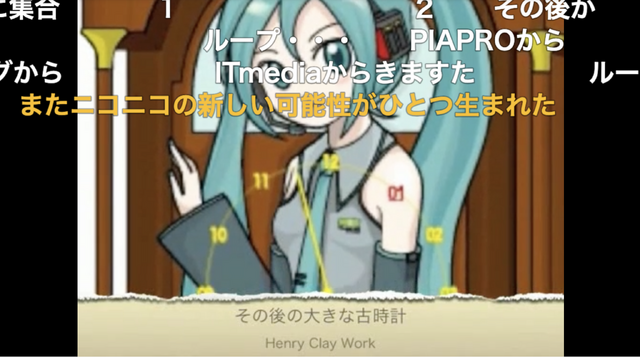

ちなみに筆者の最初期のVOCALOID曲はこちら。妻による訳詩・イラストの、パブリックドメイン曲カバーです(初出はニコニコ動画)。

特設サイトには当時の関係者へのインタビューなど貴重な話がたくさん掲載されているので、歌声合成に興味のある方はぜひご覧ください。

一方、歌声合成はVOCALOIDだけではありません。その歴史的なコンテキストを知っておくことも重要です。そこで、ChatGPTとの対話で、わかっていると便利な情報をサブテキスト的にまとめてもらいました。

筆者が読んだ限りでは、事実ベースで書かれていると思います。

では、ChatGPTさん、よろしくお願いします。

質問:VOCALOIDの歴史を調べて、年毎の重要なトピックを箇条書きでまとめて

VOCALOIDの歴史を年毎の重要なトピックとしてまとめました。

2000年代

2000年

ヤマハが音声合成技術「VOCALOID」の研究開発を開始。

2003年

ヤマハが音声合成エンジン「VOCALOID」を公開。

2004年

初代VOCALOID発売

「LEON」と「LOLA」(Zero-G社) が英語VOCALOIDとして発売。

日本からはクリプトン・フューチャー・メディアの「MEIKO」が登場。

2006年

「KAITO」が発売され、日本国内でVOCALOIDファンが徐々に増える。

2007年

初音ミク登場

クリプトン・フューチャー・メディアが「初音ミク」を発売し、爆発的な人気を獲得。

ニコニコ動画を中心にファンメイドの楽曲や動画が投稿され、VOCALOID文化が急成長。

鏡音リン・レン発売

初音ミクに続くデュオボイスのVOCALOIDとしてリリース。

2010年代

2010年

「VOCALOID2」の技術を進化させた「VOCALOID3」が発表され、多言語対応が強化。

2011年

「VY1」と「VY2」が日本語VOCALOIDの高音質モデルとして注目を集める。

2012年

IA(LiaをベースにしたVOCALOID)が発売

高音質と美しい声で新たなファン層を開拓。

2014年

「VOCALOID4」がリリース。グロウルやクロスシンセシス機能が追加され、多様な表現が可能に。

2016年

初音ミクが10周年を迎え、多くの記念イベントやコンサートが開催。

2020年代

2020年

「VOCALOID5」がリリースされ、より直感的な操作と音声編集機能を提供。

2023年

初音ミクを中心としたVOCALOID関連技術がAIと統合され、AI音声合成の研究が進む。

プロフェッショナル向けに特化した高音質モデルの台頭。

2024年

世界的にAIボーカルと伝統的VOCALOIDの共存が進み、新たなクリエイティブプラットフォームとして発展中。

VOCALOIDは、技術進化と共にユーザー文化が独自に成長し、音楽シーンを革新してきたと言えます。

質問:他の歌声合成、AIによる歌唱合成も含めて記述して

VOCALOIDだけでなく、他の歌声合成やAIによる歌唱合成も含めた歴史を年表としてまとめました。

2000年代

2000年

ヤマハが音声合成技術「VOCALOID」の研究開発を開始。

2004年

初代VOCALOID発売

「LEON」「LOLA」(Zero-G社) と日本の「MEIKO」が登場。

2006年

「KAITO」が発売、日本市場におけるVOCALOIDの認知度が向上。

2007年

初音ミク登場

日本でVOCALOIDブームが本格化。

ニコニコ動画を中心にユーザー生成コンテンツが爆発的に増加。

2008年

UTAUが登場。

無料で利用できる歌声合成ソフトとして普及し、ユーザーが自作音声を登録可能に。

2010年代

2010年

ヤマハが「VOCALOID3」を発表し、多言語対応が強化。

英語や中国語のボイスバンクが登場。

2011年

中国の歌声合成技術「洛天依(Luo Tianyi)」が発表され、中国市場でも歌声合成が普及。

2012年

IA発売

高品質な音声合成技術を採用し、ユーザー層を拡大。

CeVIO Creative Studioが登場。

VOCALOIDとは異なる技術で、感情豊かな歌声やセリフの生成が可能に。

2014年

VOCALOID4がリリースされ、グロウルやクロスシンセシス機能で表現力が向上。

CeVIOから「ONE」が登場し、次世代の音声合成キャラクターとして注目。

2017年

AI歌声合成の研究が進展。

初の深層学習を利用した歌唱生成システムが研究段階で公開される。

2018年

Synthesizer Vリリース。

AIによる高品質な歌声生成が可能となり、歌唱のリアルさが大幅に向上。

2020年代

2020年

VOCALOID5がリリースされ、より使いやすいインターフェースと機能が追加。

Synthesizer V AI版が登場し、よりリアルで柔軟な歌声生成を実現。

中国で「MUTA」などのAI歌声合成ソフトが注目を集める。

2021年

OpenAIが「Jukebox」を公開。

AIが既存アーティストのスタイルを模倣して楽曲を生成する技術が話題に。

2022年

Microsoftが「VALL-E」を発表。

数秒の音声サンプルから歌唱を含む音声生成が可能に。

2023年

Googleが「MusicLM」を公開。

テキストプロンプトを入力すると、AIが楽曲や歌声を生成できる新技術が登場。

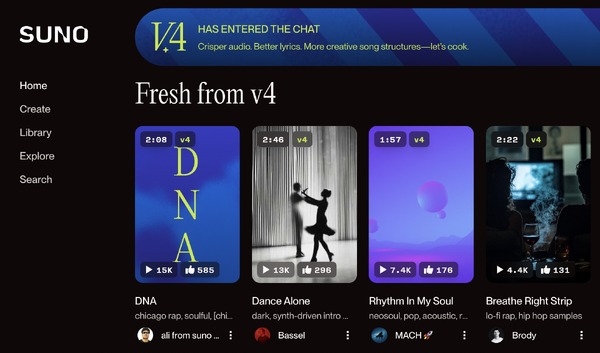

Sunoが商業リリースされ、誰でも簡単に歌声合成を試せるプラットフォームとして人気に。

2024年

Luma Dream MachineやRunway Gen-3が登場し、ビジュアルや歌声をAIで統合する次世代クリエイティブツールが普及。

AI歌声生成技術が商業音楽制作やライブパフォーマンスで本格的に活用され始める。

歌声合成技術の進化の特徴

手軽さの向上: 無料や低価格のソフトウェア(UTAU、CeVIOなど)がクリエイターを拡大。

AIの導入: 深層学習技術により、リアルな歌唱や感情表現が可能に。

多言語対応: 英語、中国語、韓国語など、多国籍展開が進行。

エンタメと融合: ミュージックビデオ、ライブ演出、商業音楽への本格導入。

歌声合成技術は、音楽制作だけでなく映像や演劇など多様な分野に広がり、今後も進化が期待されています。

質問:初期VOCALOIDの波形接続方式とCeVIOの隠れマルコフ統計学的手法、Googleが手がけたRNNなどの技術的分析も加えて

VOCALOIDや他の歌声合成技術の技術的分析を以下にまとめます。それぞれの方式がどのように音声を生成しているか、またその特徴について解説します。

初期VOCALOIDの波形接続方式

技術概要

初期のVOCALOIDは、波形接続方式(Concatenative Synthesis)を採用。

事前に録音された人間の音声サンプル(ユニット)を収録し、それを繋ぎ合わせることで歌声を生成する。

特徴

データベース構造:

歌声の音素やフレーズごとに録音された波形をデータベースとして利用。

音素間のスムーズな接続を実現するために、音素間のピッチやエンベロープを調整。

生成プロセス:

歌詞(音素列)とメロディ(ピッチ列)を入力として、最適な音素波形を選択。

波形を時間伸縮(タイムストレッチ)や音高変換(ピッチシフト)で調整し、最終的に接続。

制限と課題:

音声の自然さに制限があり、長いフレーズや急激なピッチ変化には不自然さが目立つ。

データベースの録音品質と種類に依存。

CeVIOの隠れマルコフ統計学的手法

技術概要

CeVIOでは、隠れマルコフモデル(HMM) を用いた音声合成技術が採用されました。

HMMは、統計的に最適な音声パラメータを生成することで、自然な音声を生成します。

特徴

HMMによる生成:

音声データを解析して音素ごとの特徴量(ピッチ、フォルマント、タイミングなど)を学習。

ユーザーが入力する歌詞やメロディに基づき、HMMが音声のタイミングやピッチを生成。

表現力の向上:

音声波形を直接接続する方式よりも、自然なイントネーションや音声のなめらかさを実現。

感情表現のパラメータを制御することで、感情豊かな音声合成が可能。

制限:

初期のHMMベースでは、データベースサイズが小さいと品質が低下する傾向。

Googleが手がけたRNN(Recurrent Neural Network)技術

技術概要

Googleが音声合成の分野で採用したのは、リカレントニューラルネットワーク(RNN) やその進化系(LSTM、GRUなど)を基盤とした深層学習手法。

特に、音声波形の時間的変化をモデル化するのに優れている。

特徴

WaveNet:

Google DeepMindが発表したWaveNetは、音声波形そのものを直接生成する画期的な手法。

音声波形の時間的変化をサンプリング単位でモデル化。

非常にリアルで自然な音声を生成可能。

RNNの応用:

音声の時間的依存性をモデル化するのに適しており、歌唱や音素間のスムーズな遷移を実現。

特にピッチ変化やイントネーションが多い歌唱音声で強みを発揮。

進化:

Transformerベースの音声合成(例: Tacotron2)に発展。より高速かつ高品質な音声生成が可能に。

技術比較と進化

技術 | 主な方式 | メリット | デメリット |

|---|---|---|---|

初期VOCALOID | 波形接続方式 | 簡単で計算資源が少ない | 音声が不自然になりやすい |

CeVIO | 隠れマルコフモデル | 滑らかで感情表現が可能 | 統計モデルの限界 |

Google WaveNet | 深層学習(RNN) | 非常にリアルな音声生成 | 計算コストが高い |

Transformer系 | Tacotron2, MusicLM等 | 高速かつ高品質 | トレーニングデータが多量必要 |

結論

初期VOCALOIDは簡素な技術ながら、歌声合成の文化的な基盤を築いた。

CeVIOは感情表現を重視し、自然さを向上。

WaveNetやTransformer技術は、リアルさと多様性で歌声合成の未来を切り開いている。

これらの技術はそれぞれの時代背景に最適化され、現在ではAIと統合されたハイブリッドモデルが主流となっています。

質問:Diff-SVC、RVCといったAI手法を用いたAIボイスチェンジャー、ボイスクローンも含めて解説して

最近のAI技術の進展により、Diff-SVCやRVC (Retrieval-based Voice Conversion) といった音声変換(ボイスチェンジャー)やボイスクローン技術が登場しました。これらの技術は、歌声や話し声をリアルタイムまたは非リアルタイムで別の声質に変換するために使用されています。それぞれの特徴と技術を以下に解説します。

Diff-SVC(Denoising Diffusion Probabilistic Models for Singing Voice Conversion)

技術概要

Diffusionモデルを用いた歌声変換技術。元々は画像生成で注目されたDiffusionモデルを音声に応用。

入力された歌声を別の声質に変換しつつ、高い品質と自然さを維持する。

特徴

高品質な生成:

Diffusionモデルは、ノイズの多い状態から徐々にクリーンな音声を生成するプロセスを通じて、リアルな音声を生成。

変換後の音声は元の歌声のニュアンスを保持しつつ、異なる声質に変換。

歌声特化:

特に歌声のピッチや表現力を重視し、音楽用途に適している。

課題:

リアルタイム処理には向いていないことが多く、計算コストが高い。

RVC(Retrieval-based Voice Conversion)

技術概要

RVCは、事前に登録された音声データベースから特徴を取り出し、入力音声に適用することで声を変換する技術。

Retrieval(検索)とVoice Conversion(音声変換)の組み合わせにより、効率的かつ高品質な変換を実現。

特徴

データベース依存型:

登録された音声(ターゲット音声)をベースに変換を行う。

声質の特徴を的確に捉えるため、比較的少量のデータでも高品質な変換が可能。

リアルタイム対応:

高速な処理が可能で、ライブ配信やリアルタイムのボイスチェンジに適している。

音声モデリング:

入力音声のフォルマントやピッチなどを解析し、ターゲット音声に似せた特徴を付加。

課題:

登録データの品質や量が変換結果に強く影響。

ライセンスやプライバシー問題(クローンしたい声が著名人の場合など)が議論されている。

ボイスクローン技術(Voice Cloning)

技術概要

ボイスクローンは、対象の音声データを学習し、同じ声質で新しいフレーズや歌声を生成する技術。

深層学習(Deep Learning)を基盤とし、WaveNetやTransformerモデルなどを利用。

特徴

少量データで学習可能:

最新の技術では、数秒~数分の音声サンプルで声質を再現。

MicrosoftのVALL-EやGoogleのTacotronが代表例。

高度な適応性:

話し方の癖や感情表現も模倣可能。

特定の言語やアクセントにも適応。

用途:

声優の代替や、ゲームキャラクターの音声生成、アシスタントボイスのパーソナライズ。

課題:

プライバシー侵害や著作権問題が指摘されている。

AI生成音声の識別が難しくなる可能性。

技術の進化と比較

技術 | 主な方式 | メリット | デメリット |

|---|---|---|---|

Diff-SVC | Diffusionモデル | 高品質で自然な歌声変換 | リアルタイム処理が難しい |

RVC | 検索ベース音声変換 | リアルタイム対応、高効率 | 登録データに依存 |

ボイスクローン | 深層学習(WaveNet, Transformer) | 声質や感情を忠実に模倣可能 | プライバシーや著作権の懸念 |

応用例

エンターテインメント:

ライブ配信でのボイスチェンジ(VTuberなど)。

音楽制作における仮歌の生成。

ビジネス:

パーソナライズされた音声アシスタント(例: SiriやAlexa)。

教育コンテンツで多言語対応音声の生成。

ソーシャル問題:

詐欺やディープフェイク音声への悪用。

プライバシー侵害や倫理的課題。

最新の技術では、Diff-SVCやRVCを中心に、リアルタイム処理と高品質な音声変換を両立する方向に進化しています。一方で、これらの技術が社会に与える影響についても、倫理的な観点から議論が必要です。

質問:DreamtonicsのVocoflexはリアルタイム処理が可能なボイスチェンジャー技術。これについても考察を追加して

DreamtonicsのVocoflexは、リアルタイムでのボイスチェンジを可能にする最新の技術として注目されています。この技術は、歌声合成エンジンSynthesizer Vで培われた高度な音声生成技術を基盤にしています。以下に技術の特徴と考察をまとめます。

Vocoflexの特徴

技術概要

Vocoflexは、入力音声をリアルタイムでターゲットの声質に変換するボイスチェンジャー技術です。

Dreamtonicsが開発した歌声合成技術(Synthesizer V)のコア部分を応用し、リアルタイム処理の高速化と高精度な音声変換を実現しています。

技術的な強み

リアルタイム処理

Vocoflexは、音声変換をリアルタイムで行うため、ライブ配信や即時応答が求められる場面での使用に適している。

レイテンシが極めて少なく、ユーザーがストレスなく利用可能。

高い表現力

Vocoflexは歌声合成で培った技術を応用しており、ピッチ変動やダイナミクスの繊細な表現が可能。

特に歌声や感情の表現に優れており、話し声にも適用できる柔軟性がある。

音声の自然さ

音声変換後も元のニュアンスを保持しつつ、ターゲットの声質を忠実に再現。

高品質なフォルマントシフトやピッチ調整が可能で、違和感が少ない仕上がり。

用途の広さ

ライブ配信、VTuber、音楽制作、ゲームキャラクターの声変換など、多岐にわたる用途に対応。

特にリアルタイム性が必要なVTuberやライブパフォーマンスにおいて大きな強みを発揮。

技術の中核

Vocoflexのリアルタイム性を実現するために、以下の技術が考えられます:

音声エンコーディング

入力音声を高速でエンコードし、音声の特徴を抽出。

ニューラルボイス変換

特徴抽出後、事前学習済みモデルによってターゲット音声への変換を行う。

WaveNetに似た生成モデルまたはTransformer系の軽量化モデルが使用されている可能性。

リアルタイム処理の最適化

高速な推論エンジンにより、遅延を最小化。

GPUや高性能CPUを活用することで、高度な音声処理を実現。

Vocoflexのメリットと課題

メリット

ライブパフォーマンスでの即応性:

VTuberやアーティストがリアルタイムでキャラクターの声に変換可能。

シームレスな統合:

Synthesizer Vエコシステムとの連携がスムーズ。

高い音声品質:

ボイスチェンジャーでありながら、音声の自然さを損なわない。

課題

ハードウェア依存:

リアルタイム処理のため、高性能なハードウェアが必要になる場合がある。

ターゲット声質データの準備:

十分なクオリティのターゲット音声データが必要。

倫理的課題:

ボイスクローン技術全般と同様に、プライバシー侵害や悪用の可能性が懸念される。

他技術との比較

技術 | 主な方式 | 特徴 | 主な用途 |

|---|---|---|---|

Vocoflex | リアルタイムニューラル変換 | 高速処理と高品質な変換 | VTuber、ライブ配信、音楽制作 |

Diff-SVC | Diffusionモデル | 高品質で自然な歌声 | 音楽制作 |

RVC | 検索ベース音声変換 | 高速で効率的 | ボイスチェンジャー、話し声変換 |

ボイスクローン | 深層学習(WaveNet等) | 声質や感情を忠実に再現 | 声優代替、音声生成 |

Vocoflexの未来展望

エンタメ業界での普及

VTuberや音楽アーティストが新しい表現手段として活用。

ユーザーエクスペリエンスの向上

個人の声をカスタマイズしたAIアシスタントやゲームキャラクターでの活用が期待される。

倫理的ガイドラインの整備

AI音声生成技術の適正利用を促進するルールの策定が重要。

Vocoflexは、リアルタイムボイスチェンジャーとして、利便性と品質の両立を図った革新的な技術であり、エンターテインメントやパーソナライズされた音声体験を一段と進化させる可能性を秘めています。

質問:筆者がまとめた歌声合成年表を元に、VOCALOID登場までの技術的な流れをまとめて

1960年代

1961年: Bell Labs(ベル研究所)が「IBM 704」を使用して音声合成を実演。

「Daisy Bell(デイジー・ベル)」をコンピュータが歌ったことで、歌声合成技術の先駆けとなる。

この技術は物理モデルを基盤とし、フォルマントを調整することで音声を生成。

1980年代

1984年: アタリ社が「Atari Speech Synthesizer」を開発。

初期の商用音声合成システムとして登場し、音楽制作やエンターテインメント用途に利用。

1985年: DECtalkが発表される。

初期の音声合成装置で、Stephen Hawking氏の声として知られる。

1990年代

1993年: 日本の東京大学で「CHATR」システムが開発される。

統計的手法を用いて自然な音声合成を実現する試み。

波形接続方式の一形態で、後のHMMベース技術に影響を与える。

1997年: ATR研究所が「HMM(隠れマルコフモデル)」を応用した音声合成技術を提案。

フォルマントベースの手法から統計的音声合成へとシフト。

1999年: Bell Labsが「LPC(線形予測符号化)」技術を利用した歌声合成を開発。

この手法は低データ量で音声を生成可能で、リアルタイム処理に適していた。

2000年代

2000年: 米国カーネギーメロン大学が「Festival Speech Synthesis System」を発表。

オープンソース音声合成フレームワークとして、研究コミュニティで広く利用される。

歌声にも応用され、UTAUの開発に間接的な影響を与えた可能性がある。

2002年: 米国AT&T研究所が「Natural Voices」をリリース。

商業用音声合成技術で、歌声生成の可能性も研究される。

2003年: 東京大学嵯峨山研究室が「Orpheus」を開発。

楽譜情報から歌声を生成する初期の試みで、日本国内の音声合成研究を牽引。

VOCALOID登場(2004年以降)

VOCALOIDが登場した2004年以降、歌声合成技術はヤマハのVOCALOIDを中心に急速に発展。しかし、それ以前の技術的基盤は多岐にわたり、特に統計的手法や波形接続方式が重要な役割を果たしている。

考察

VOCALOID以前の歌声合成技術は以下のような特徴があります:

物理モデルから統計モデルへの進化

初期はフォルマントや波形接続方式が中心だったが、1990年代以降は統計モデル(HMM)が導入され、自然さが向上。

研究から商業利用へ

1960年代~1980年代は研究用途が中心だったが、1990年代以降は商業用音声合成ソフトウェアが登場。

国際的な影響

日本(ATR、東京大学)や米国(Bell Labs、AT&T)が中心となり、技術的進化をリード。

この流れが、後のVOCALOIDやUTAU、CeVIOといった日本独自の歌声合成文化を育む基盤となりました。