1週間の気になる生成AI技術・研究をいくつかピックアップして解説する連載「生成AIウィークリー」から、特に興味深いAI技術や研究にスポットライトを当てる生成AIクローズアップ。

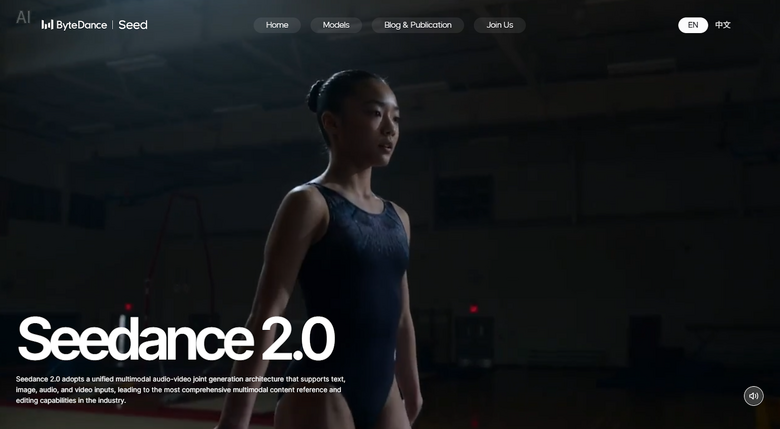

今回は、公開直後から国際的な著作権紛争を巻き起こしているByteDance開発の動画生成AI「Seedance 2.0」を取り上げます。

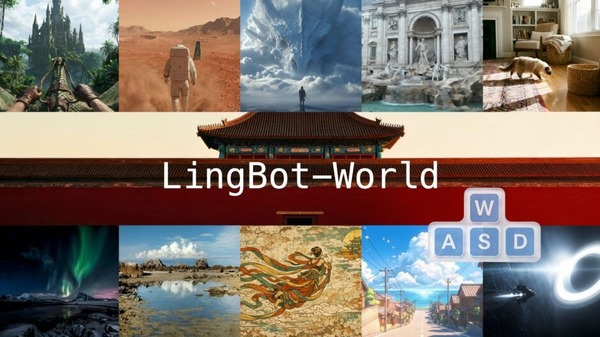

Seedance 2.0を用い、2行のプロンプトで生成したトム・クルーズ対ブラッド・ピットの格闘映像がSNSで拡散すると、スパイダーマンやロード・オブ・ザ・リングといったハリウッドIPを使った動画が次々と投稿されました。しかも、ウォーターマーク(透かし)が入っていないことも怒りを加速させています。

米国映画協会(MPA)が大規模な著作権侵害だとして停止を要求。俳優組合SAG-AFTRAも非難声明を出し、ディズニーはByteDanceに差し止め請求書を送付したといいます。

日本のアニメキャラクターも標的になり、SNS上では、ウルトラマンや名探偵コナンのキャラクターが高市早苗首相と戦う動画、孫悟空とドラえもんが対決する動画などが出回りました。

人工知能戦略や知的財産戦略担当も担う小野田紀美大臣(内閣府特命担当大臣)は2月13日の閣議後会見で「著作権者の許諾がなく既存の著作物が活用される状況であれば看過できない」と明言し、関係省庁と連携してByteDanceとの対話を含む実態把握を急ぐよう事務方に指示したことを明らかにしています。

日本アニメフィルム文化連盟(NAFCA)は、2024年にアニメ業界の持続的発展を目的としてTikTok Japan(ByteDance日本法人)から寄付を受けた経緯があることから、本件はその趣旨に逆行するのではないかとして同社に問い合わせました。TikTok Japan側からは、当該AIモデルは正式公開前のものであり、現在速やかに対応を進めているとの回答があったとNAFCAが公表しています。

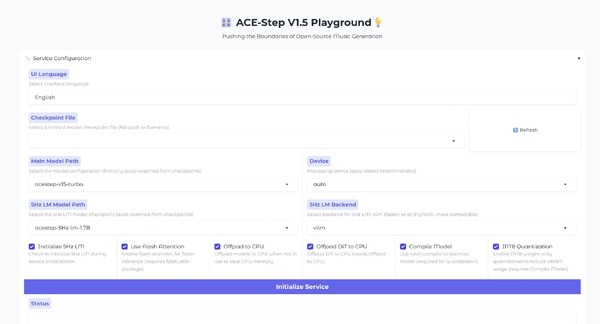

技術面を整理しておきます。Seedance 2.0は、テキスト・画像・動画・音声の4種類の入力を同時に受け付けるマルチモーダルモデルです。最大で画像9枚、動画3本、音声ファイル3つを一度にアップロードでき、それらを参照素材として統合した映像を出力します。解像度は最大2K、映像と音声を同時に生成し、リップシンクや環境音まで一発で出てきます。

実在する一般人の顔写真と声サンプルからAI動画は作れるのか?

中国の映像クリエイターであり、MediaStormの創設者Tim氏が、Seedance 2.0のレビュー動画をbilibiliで公開しました。映像業界を変えるAIの性能の高さとその恐ろしさをレビューしています。

Tim氏がSeedance 2.0を恐怖と表現したのは、自分の顔写真を使ったテスト時のことです。彼が自分の顔写真を1枚アップロードすると、音声ファイルもテキスト指示も一切与えていないにもかかわらず、AIは彼本人と酷似した声を自動生成したといいます。

これが事実であれば、従来のボイスクローン技術は最低でも数秒の音声サンプルを必要としていましたが、音声サンプルなしで生成したことになります。つまり、顔の画像だけから声の特徴を推測する能力を持っていた可能性があります。

しかし、別の人物の顔写真で試したところ、その人物の顔で動画が生成されたものの本人の声ではありませんでした。これらの結果からTim氏は、自身がこれまで公開してきた動画がモデルの学習データに含まれていたと推測しています。承諾を受けたわけではないため、無断で学習されたと述べています。

この騒動を受け、ByteDanceはSeedance 2.0において実在の人物素材を主体参照として入力する機能を当面停止したと、複数の中国メディアが報じています。要するに、現段階では実在する他人の顔写真と声サンプルを使ってAI動画を生成するのはできないようにしたということです。ただし、一部のアプリでは、自身の映像と音声を使ってライブ認証を行えば、自分自身のデジタル分身を作成してAI動画に出演させることは可能とのことです。