この1週間の気になる生成AI技術・研究をいくつかピックアップして解説する今回の「生成AIウィークリー」(第110回)は、4人会話の90分ポッドキャスト番組を生成できる音声合成モデル「VibeVoice」や、微調整なしでAIエージェントを進化させる記憶ベースの学習手法「Memento」を取り上げます。

また、小型モデルで巨大モデルの性能を上回るMicrosoftが開発した数学推論AI「rStar2-Agent」、オープンソースでありながらGPT-5にもう少しの性能を実現したマルチモーダルAI「InternVL3.5」をご紹介します。

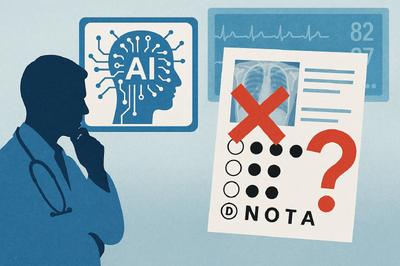

そして、生成AIウィークリーの中でも特に興味深いAI技術や研究にスポットライトを当てる「生成AIクローズアップ」では、医学ベンチマークテストで高い正答率を誇る大規模言語モデル(LLM)が、実際には医学的推論を行っているのではなく、訓練データのパターンを認識しているだけかもしれないという問題提起をしたスタンフォード大学の研究を別の単体記事で取り上げています。

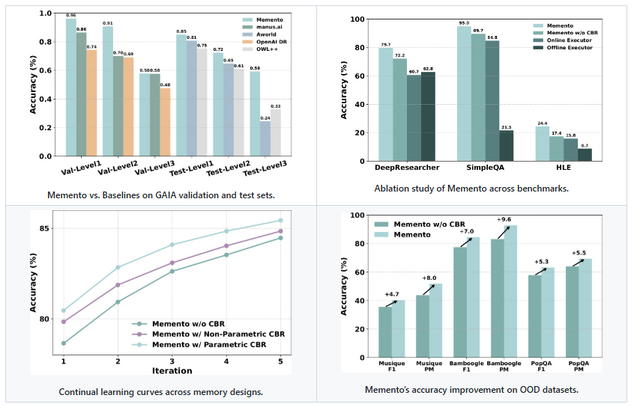

ファインチューニング不要でLLMエージェントを進化させる記憶ベースの学習手法「Memento」

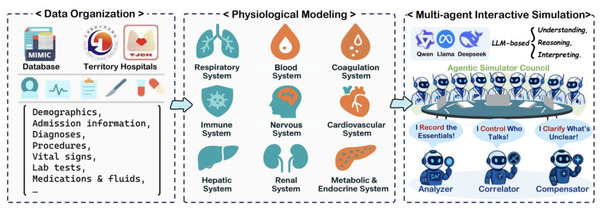

「Memento」は、LLMのパラメータを更新せずにAIエージェントの性能を向上させる手法です。

従来のLLMエージェントは、性能向上のために膨大な計算コストをかけてモデル自体をファインチューニングする必要がありました。Mementoは、人間の記憶メカニズムに着想を得て、過去の成功例と失敗例を外部メモリに保存し、類似した問題に直面した際にこれらの経験を参照することで継続的な学習を実現します。

システムは、計画を立案するプランナー(GPT-4.1)と、実際のタスクを実行するエグゼキューター(o3/o4-mini)で構成されています。ケースベース推論という手法により、過去の経験から最も関連性の高いケースを取得し、新しい問題の解決に活用します。

実験結果では、GAIAベンチマークで最高水準の精度を達成し、DeepResearcherデータセットでも既存の訓練ベース手法を上回る成績を記録しました。特に、未知のタスクに対しても高い性能向上を示し、経験からの汎化能力が実証されています。

Memento: Fine-tuning LLM Agents without Fine-tuning LLMs

Huichi Zhou, Yihang Chen, Siyuan Guo, Xue Yan, Kin Hei Lee, Zihan Wang, Ka Yiu Lee, Guchun Zhang, Kun Shao, Linyi Yang, Jun Wang

Paper | GitHub

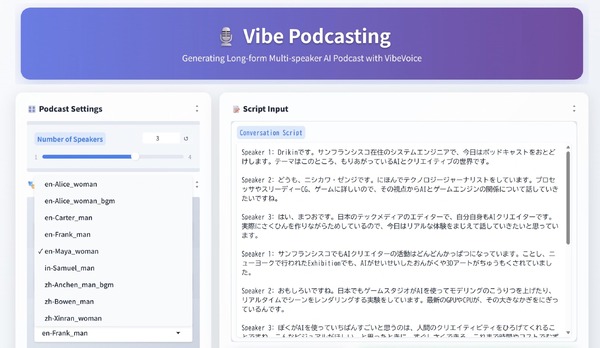

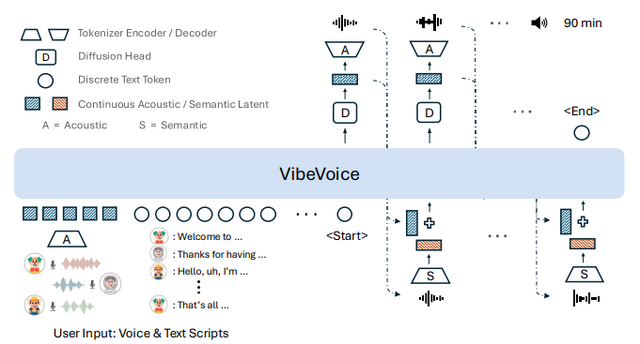

4人会話の90分ポッドキャスト番組を生成できるオープンソース音声合成モデル「VibeVoice」

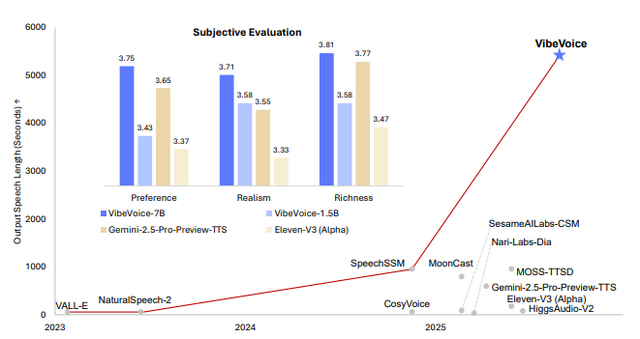

Microsoftの研究チームが、最大90分間の長時間会話音声を複数話者で生成できるオープンソース音声合成モデル「VibeVoice」を発表しました。このTTS(Text to Speech)モデルは、ポッドキャストといった複数人(最大4人の異なる話者)による会話形式の音声コンテンツを生成することができます。

VibeVoiceは、独自開発した低フレームレート(毎秒7.5トークン)の音声トークナイザーが特徴。これにより、従来のEncodecモデルと比較して80倍のデータ圧縮を実現しながら、同等の性能を維持しています。システムの中核には大規模言語モデルQwen2.5を採用し、1.5Bと7Bパラメータの2つのバージョンを提供しています。

評価実験では、音声の自然さ、表現力、全体的な好ましさのすべての指標において、GoogleのGemini 2.5 Pro Preview TTSやElevenlabs v3 alphaなどの競合モデルを上回る結果を示しました。また、単語誤り率も低く、長時間音声や短い発話でも優れた性能を発揮しています。

現時点での制限として、対応言語は英語と中国語のみで、話者同士の声が同時に重なる会話、背景音、音楽、効果音は扱えません。

VibeVoice Technical Report

Zhiliang Peng, Jianwei Yu, Wenhui Wang, Yaoyao Chang, Yutao Sun, Li Dong, Yi Zhu, Weijiang Xu, Hangbo Bao, Zehua Wang, Shaohan Huang, Yan Xia, Furu Wei

Project | Paper | GitHub

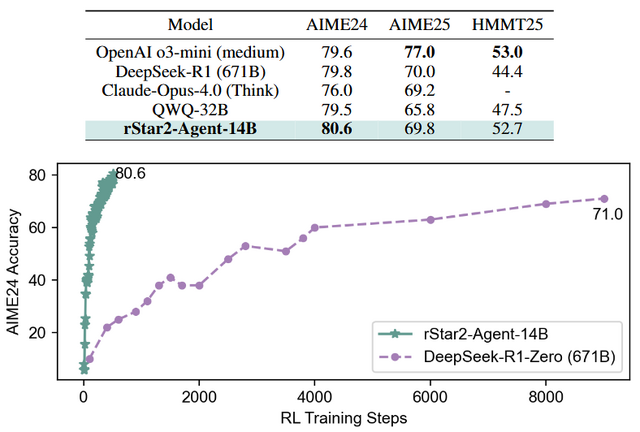

Microsoft、14Bパラメータの小型モデルで巨大モデルの性能を上回る数学推論AI「rStar2-Agent」を開発

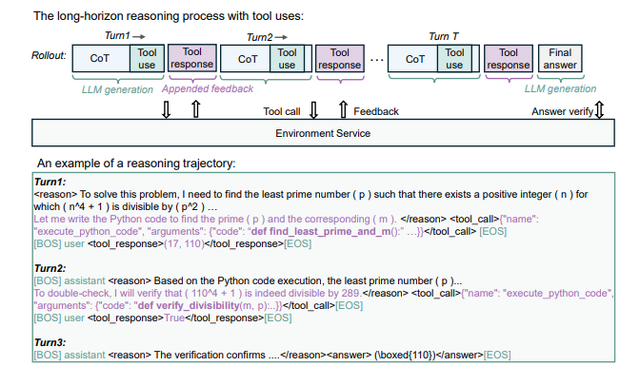

マイクロソフトリサーチが開発した14Bパラメータの数学推論モデル「rStar2-Agent」が、671Bパラメータを持つDeepSeek-R1などの巨大モデルと同等以上の性能を達成しました。

特徴は、Pythonコード実行環境を活用した「エージェント型強化学習」にあります。従来の手法が単に長い思考連鎖(Chain-of-Thought、CoT)を生成するのに対し、rStar2-Agentはコードを書いて実行し、その結果を検証しながら自律的に推論を改善できます。

技術として、「GRPO-RoC」という新しい強化学習アルゴリズムを開発しました。これは、正解した推論の中から高品質なものを優先的に学習し、コード実行時のエラーなどのノイズを効果的に除去します。また、45,000の同時実行に対応する高速実行環境と、GPU利用を最適化する仕組みも構築しました。

訓練はわずか510ステップ、64個のGPU(MI300X)で1週間という限られたリソースで完了しました。精度評価では、AIME24でOpenAI o3-mini、Claude-Opus-4.0、DeepSeek-R1などを上回っています。

rStar2-Agent: Agentic Reasoning Technical Report

Ning Shang, Yifei Liu, Yi Zhu, Li Lyna Zhang, Weijiang Xu, Xinyu Guan, Buze Zhang, Bingcheng Dong, Xudong Zhou, Bowen Zhang, Ying Xin, Ziming Miao, Scarlett Li, Fan Yang, Mao Yang

Paper | GitHub

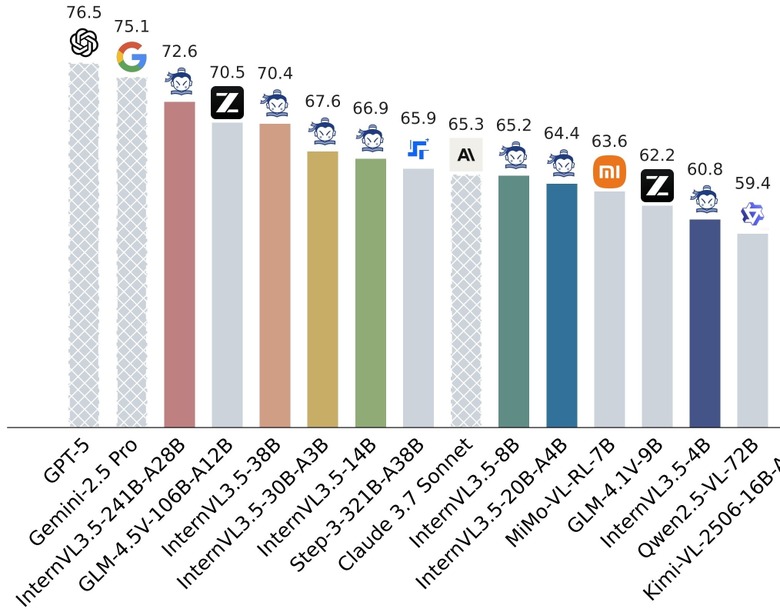

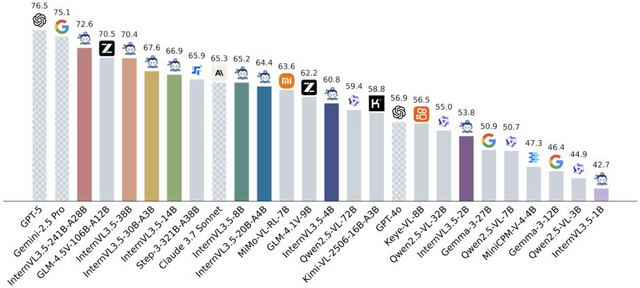

GPT-5に迫る性能を無料で実現、オープンソース・マルチモーダルAI「InternVL3.5」

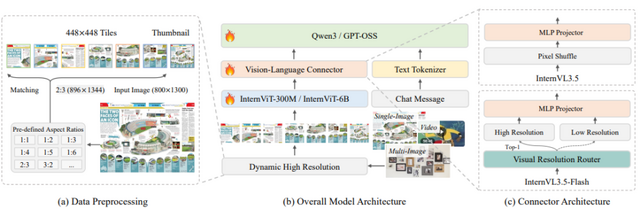

上海AIラボラトリーが、マルチモーダル大規模言語モデル「InternVL3.5」を発表しました。このモデルは画像、動画、テキストを統合的に理解し、複雑な推論タスクを処理できる新しいAIシステムです。

新しく開発された「Cascade Reinforcement Learning」(Cascade RL)により、前世代のInternVL3と比較して推論性能が最大16%向上しました。この手法はオフライン学習とオンライン学習を組み合わせ、より効率的で安定した学習を実現しています。

推論速度の面でも大きな進歩があります。「Visual Resolution Router」(ViR)により、性能を維持しながら視覚処理に必要なトークン数を50%削減し、新しいデプロイメント手法により推論速度を最大4.05倍まで向上させました。

InternVL3.5は1Bから241Bまでの幅広いモデルサイズを提供し、すべてオープンソースとして公開しています。最大モデルは複数のベンチマークで優れた成績を収め、商用モデルGPT-5との性能差を3.9%まで縮小しました。

InternVL3.5: Advancing Open-Source Multimodal Models in Versatility, Reasoning, and Efficiency

InternVL Team, Shanghai AI Laboratory

Paper | GitHub