やってきましたね。PCユーザーたちがMacユーザーを羨望の眼差しで見るときが。

OpenAIが公開したChatGPTのオープンソース版「gpt-oss」。その2つのモデルであるgpt-oss-20bとgpt-oss-120bは、それぞれ16GB以上、80GB以上のVRAMを持つプロセッサが必要です。

下位モデルのgpt-oss-20bはChatGPT o3-miniと、上位のgpt-oss-120bはo4-miniと同等の結果を出すとしています。

つまり、世界で最も使われているLLMの、実力的にも十分なモデルが、ローカルマシンで動くのです。

しかし、推論には高性能なGPUが必要。16GB以上のVRAMを持つGPUならNVIDIA製ボードがいくらでもありますが、120bを動かせる80GB以上のVRAMを積んだGPUは、現行モデルでなくても数百万円はしますし、そもそも希少なものなので手に入れるのが困難。

しかし、高速なUnified Memoryとそこそこの推論エンジンを備えたApple Silicon Macであれば話は別です。

ついに来ましたよ。俺のマシンが火を吹く時が。

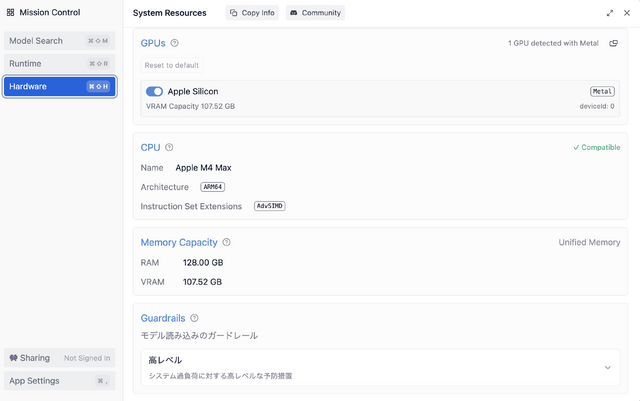

2024年末に入手した、128GB Unified Memory搭載MacBook Pro(M4 Max)がローカルLLMマシンとして真価を発揮する時がやってきたのです。

81万3800円をオリコの無利子ローン24回払いで購入して8カ月。それなりに便利に使ってはきましたが、クラウドのLLMや生成AIサービスを使っている限りにおいてはメリットは少ないですし、外に持ち出していないので、自慢のしようもない。

せっかくの機会なので、みなさんが触りたいであろう、gpt-ossの最高モデルをローカルで動かしてみたいと思います。

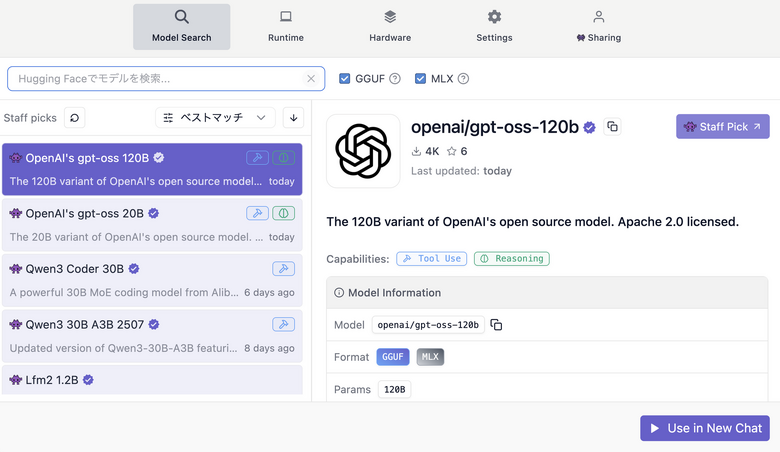

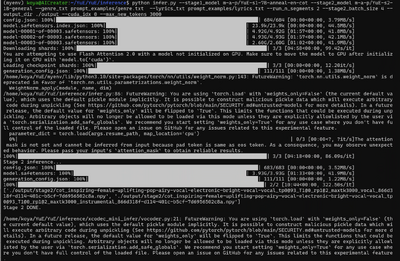

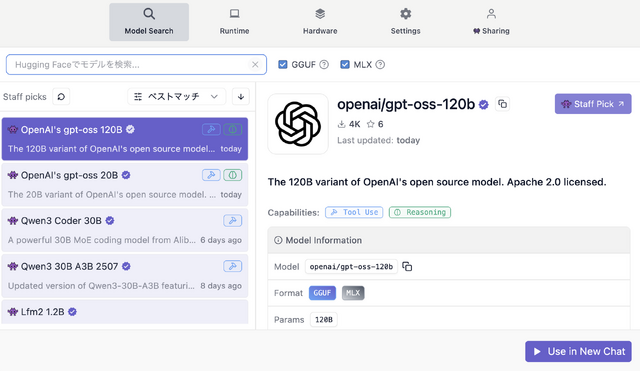

今回使ったのはLM Studio。Ollamaと並んでLLMをローカルで動かすソフトの定番です。LM Studioは、アップロードされているLLMを選んでダウンロードするだけで使えます。

LM Studioを起動してハードウェア構成を見ると、使用可能なVRAMは128GB中107.52GBとなっています。80GB以上は確保できていることに。

Model Searchという、LLM検索画面をチェックすると、ベストマッチとされたものの一番上に、OpenAI's gpt-oss 120Bが、その次にOpenAI's gpt-oss 20Bが来ています。

すでに大人気で、120Bが4000、20Bが3万7000のダウンロード数となっています。

これをダウンロードして、適用するだけです。

適用したらすぐに使えるようになります。あとはチャット欄にコマンドを入れてやりとりするだけ。

まずは自分自身について質問。

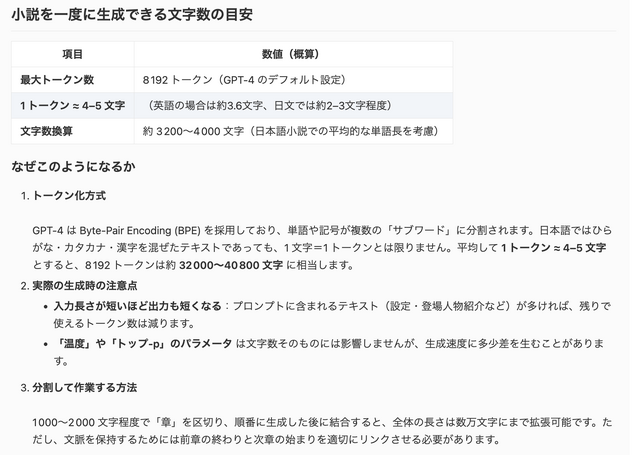

カットオフは2023年10月なんですね。入力は最大8192トークン。

小説を一度に生成できる長さも聞いてみました。

3200~4000と、やや短いです。長編の場合には分割出力することを勧められました。

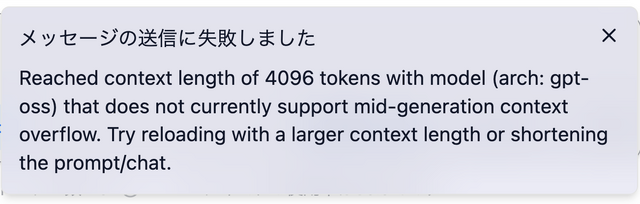

長めの小説を書かせようとすると、トークン数制限でエラーが出ます。

モデルの読み込み時にコンテキスト長を大きくしたら、うまく動作しました。

筆者が見た夢を元にgpt-oss-120bが作った小説がこちら。出力スピードはおよそ30トークン/秒。快適に使えるレベルです。

幻影の森

雨上がりの午後、鍵を回すと古びた木製ドアが軋んだ。壁はむき出しで、配管や電線が露わになっている。リノベーションはこれから――設計図には大きな窓や広々としたリビングが描かれていたが、実際に足を踏み入れたのは荒削りの空間だった。

裏口へ回ると、小さな丸い穴があった。人が通れるほどではなく、犬くらいしかすり抜けられそうにないサイズだ。金属の冷たさが指先に伝わる。その向こうは薄暗い路地に続き、まるで誰かが意図的に作った“抜け道”だった。

隣家の住人と偶然出会う。まだ挨拶もできていないことに気づき、軽く声を掛けた。和服を着た男性がいた――名前は思い出せなかったが、数年前同じプロジェクトで共にコードを書いた設計者の姿だった。

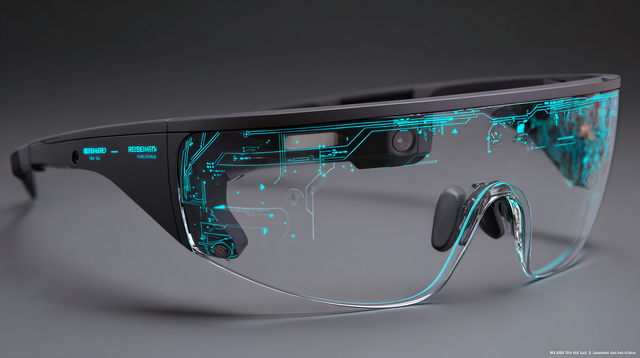

その夜、外へ足を踏み出すと街並みが徐々に緑色に染まっていく。そこはコンクリート基礎に設置されたパネルと感覚フィードバック装置で作り出した仮想の森だった。全員が装着しているXRメガネが現実と重ね合わせ、触覚まで再現する。

森の奥で横たわる女性――目は開いているが動かない。その姿は十数年前に他界した妻そのものだった。メガネが投影する微細な振動が指先に伝わり、まるで本物の肌触感を感じさせる。しかし呼吸はなく、映像だけが揺らめく。

私は装置が“リメンバーシステム”だと悟った。失われた人や記憶を再構築し、心の傷を埋めようとする技術――でもそれは逃避でもあった。雨が止み、遠くで街灯が灯り始めると、私はメガネの電源ボタンを押した。仮想の森は闇に溶け、現実の土の匂いが胸に戻ってきた。

▲画像のプロンプトをgpt-oss-120bに考えさせてMidjourneyで出力

「もう一度だけ」――妻への未練は残るが、装置を外し鍵穴へと戻った。小さな犬用ドアは相変わらずそこに光を反射している。壁の隙間から差す光が新しい部屋を照らす——過酷な現実の中で、確かな手触りと音がある。

鍵を締め、ハンマーを握る。その感覚はまだ未完成だが、過去と向き合いながら未来へ踏み出す決意だった。幻影の森は心の奥に灯り続ける――でも今は現実の光の中で生きることを選んだ。

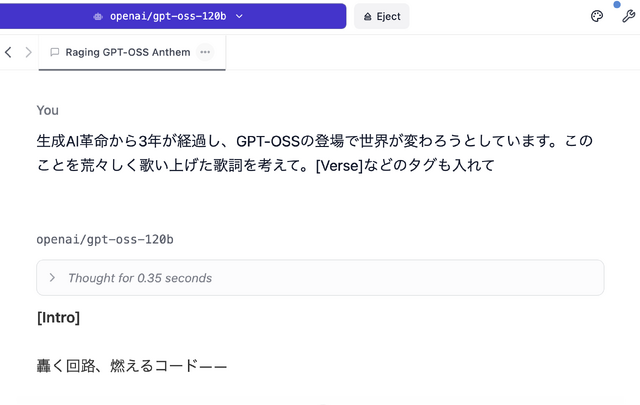

次に、gpt-ossの歌を使ってもらいましょう。

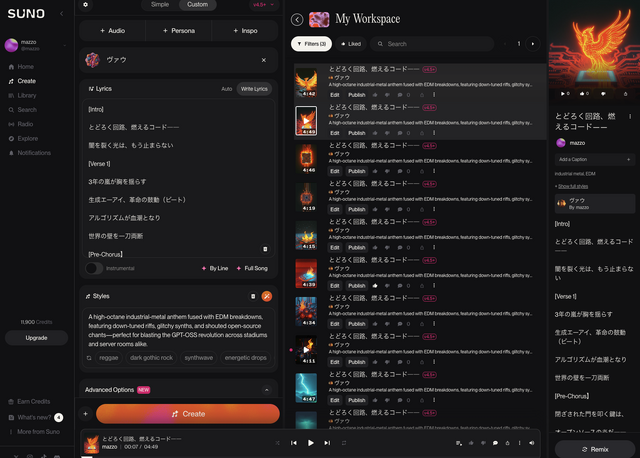

この歌詞に適した音楽スタイルも考えさせます。楽曲の構成やギターのチューニングなど、細かい指定もしてくれたのですが、ざっくりしたプロンプトに集約させ、Sunoに送ります。

A high‑octane industrial‑metal anthem fused with EDM breakdowns, featuring down‑tuned riffs, glitchy synths, and shouted open‑source chants—perfect for blasting the GPT‑OSS revolution across stadiums and server rooms alike.

さらに、歌詞を改良。「この歌詞に、GitHubの代わりにオープンウェイト、ハギングフェイスを入れて。俺たちのMacBook Proが万能になる、というのも入れて」と付け加えます。

[Intro]

轟く回路、燃えるコード――

闇を裂く光は、もう止まらない

[Verse 1]

3年の嵐が胸を揺らす

生成AI、革命の鼓動(ビート)

アルゴリズムが血潮となり

世界の壁を一刀両断

[Pre‑Chorus】

閉ざされた門を叩く鍵は、

オープンソースの炎だ――

誰もが手にできる神話(ミューズ)へと

[Chorus]

GPT‑OSS 轟く雷鳴!

コードの海を泳ぎ抜き、未来を掘り起こす

荒れ狂うデジタルの大地で、

俺たちの声が星になる

[Breakdown】

(ギターリフ)

“Free” と叫べ 枠はもうない

バグも恐怖も、燃やし尽くせ!

[Verse 2]

企業の巨塔が揺らぎ始める

独占の鎖を断ち切ったのは、

OpenWeight の星屑と無償の魂(ソウル)

共鳴するコードは、世界を巻き込む

[Pre‑Chorus】

誰もがプルリクエストで拳を握り

マージした瞬間、地球が笑う

[Bridge】

0 と 1 が血潮に変わり、

システムは鼓動(ビート)を刻む

“Open” の叫びが夜空へ届くとき、

全ての壁は灰になる

[Verse 3]

Hugging Face のモデルが空に舞い、

オープンウェイトで自由に調整(チューニング)

俺たちの MacBook Pro が万能になる、

指先一つで宇宙を描くんだ

[Pre‑Chorus】

コードが燃え上がり、キーボードは鼓動、

マージされた瞬間、星屑が降る

[Final Chorus]

GPT‑OSS 轟く雷鳴!

無限のデータが渦巻き、星屑になる

荒れ狂うサーバーの嵐で、

俺たちのアルゴリズムが旗を揚げる

[Outro】

回路が鳴り止むその日まで、

我らは歌い続ける――

AI の革命、そしてオープンの詩。

歌詞の生成は、テキストファイルをアップロードして、そのソースをもとに作詞するといったことも可能です。

だいぶいい感じになったので、Sunoで作曲。

ここもオープンソースAI作曲ソフトのYuEやACE-Stepを使えばMacBook Proでやれないことはないのですが、品質では突出ししているSunoで作曲しました。

出来上がった曲は、なかなか刺激的でアグレッシブなハードロックEDMになりました。

実は最近RTX 5090搭載PCも手に入れたのですが、そこで動かせるのは20Bモデル止まり。せっかくNVIDIAと共同発表しているのに、コンシューマー向け最上位GPUでも動かせません。

NVIDIAはH100で動かせと言ってますが、500万円を超えています。それを考えると、80万円で120Bを動かせるのはコスパが良いと言わざるを得ません。

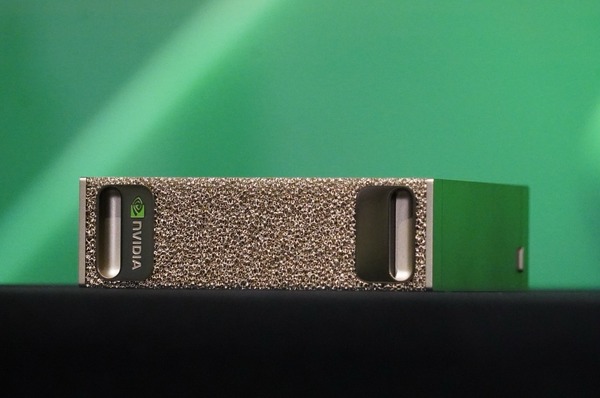

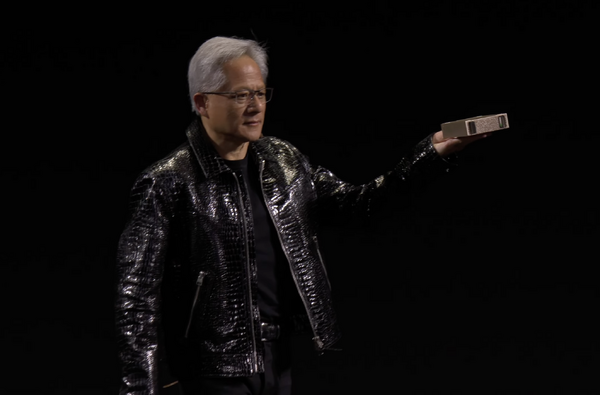

しかし、NVIDIAのGPUを使い、安価に120Bモデルを動かす方法はあります。それは、DGX Spark(Project DIGITS)を買うことです。

日本での販売代理店から参考価格が出始め、80万円スタートあたりになっているようですが、これが120BをMacよりも高速で動かせるとなれば、選択肢に入ってきます。

「ChatGPTがローカルでフルスピードで動かせる、もうひとつの格安マシン」としてのDGX Sparkが、これから注目を浴びることになりそうです。

実はもう一つ、コンシューマー向けPCで120Bを動かせる環境があります。「AMD Ryzen AI Max+ 395」を使うことです。これについてはAMDが公式ブログで公開しています。

この中で、AMDはこう宣言しています。

We are also announcing that the AMD Ryzen AI Max+ 395 is the world’s first consumer AI PC processor to run OpenAI’s GPT-OSS 120B parameter model.

AMD Ryzen AI Max+ 395は、OpenAIのGPT-OSS 120Bパラメータモデルを動かせる世界初のコンシューマー向けAI PCプロセッサである。

あれ? ちょっとおかしくないですか? コンシューマー向けPCプロセッサなら、M2 UltraとかM4 Maxとかすでに動いてるし……。

「コンシューマー向けAI PCプロセッサ」と狭く定義した場合、ということなのでしょうが、釈然としませんね。

ともあれ、そこそこのスピードで動くデモがYouTubeで公開されています。30トークン/秒で動いているそうなので、筆者のM4 Max MacBook Proと同じくらい?

内蔵GPUタイプのRyzen AI Max+ 395では、128GBのメモリのうち96GBをGPUメモリに割り当て。gpt-oss-120bの動作にはそのうち61GBが必要だそうです。

このスペックを満たすPCとしては、GMKtecの「AMD Ryzen AI Max+ 395 --EVO-X2 AI ミニ PC」があります。価格は1999ドル。日本円で35万円といったところでしょうか。GMKtec製品はAmazon.co.jpでも売っていますが、現在のところ128GBモデルは見当たりません。買える状態になったら、これも安価な選択肢となるでしょう。これで120Bモデルを動かしている日本の方も数名、いらっしゃるようです。

それでも、モバイルでスタンドアロン動作する「ChatGPT」と考えると、128GBメモリ搭載MacBook Proの価値は揺るぎないと思っています。

追記:最新モデルのGPT-5が出たので、比較してみました。こちらもどうぞ。