アップルは、毎年5月に行われれる世界各地でアクセシビリティを考える一日(Global Accessibility Awareness Day:GAAD)に合わせ、障害を持つ人たちに新たな体験を提供すべく、アップル製品への複数の新機能追加を発表しました。

今回発表された新機能のうち、iPhoneやiPadを対象とするものとしては、アイトラッキング(Eye Tracking)機能をはじめとして、カスタマイズ可能なVocal Shortcuts機能、Music Haptics機能、Vehicle Motion Cues機能などがあります。

アイトラッキング

まず、一般ユーザーでも気になりそうなアイトラッキング機能は、A12チップ以降を搭載するiPhoneまたはiPadに提供予定。

有効にすると、ユーザーはiPhoneまたはiPadの画面を見てアプリやメニューなどの要素を選び、一定時間注視することで操作できるようになります。

アップルはすでにiOSとiPadOSで、視線検出・視線追跡をサポートするMFi認証済みの外部デバイスをサポートしていますが、この新機能は追加のハードウェアなしに利用できます。

アップルが今年発売した空間コンピュータ Apple Vision Pro は、アイトラッキングと指の動きで基本の操作ができるユーザーインターフェースを採用していました。

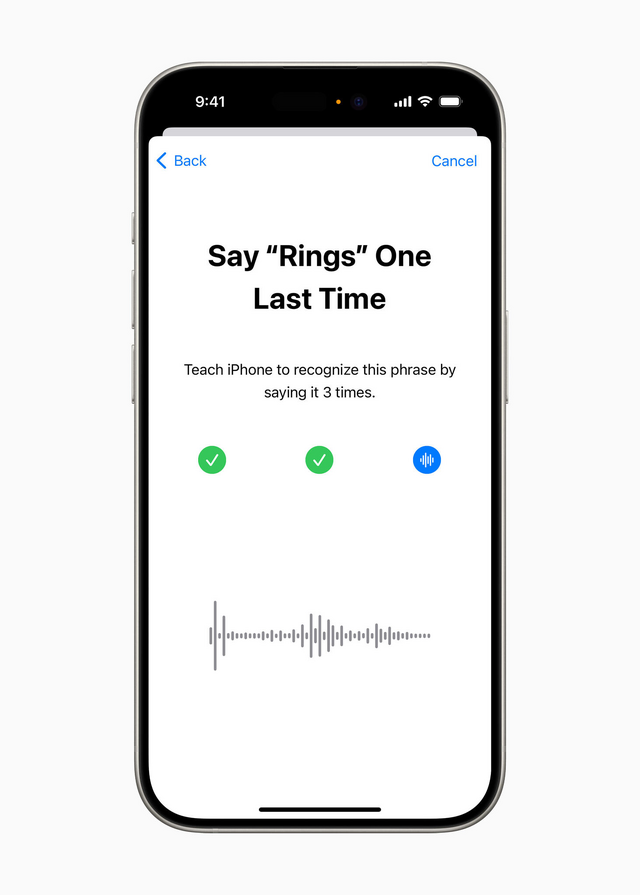

Vocal Shortcuts

Vocal Shortcutsは、AIを使い、ユーザーごとにパーソナライズされた新しい音声ショートカットを作成する機能です。

たとえば1つの単語やフレーズ、または「おーい!」と呼びかけるような発話をコマンドとして設定すれば、Siriがそれを解釈して、割り当てられた操作やタスク、アプリケーションで指定したアクションなどを実行できるようになります。

この機能では、iPhoneやiPadのデバイス上の機械学習機能を使い、その人特有の発声方法に合わせてカスタマイズして音声を認識します。

説明では「脳性麻痺、筋萎縮性側索硬化症(ALS)、脳卒中など、発話に影響を及ぼす後天的または進行性の疾患を持つユーザーのために設計されている」と表現しています。この機能の構築にはイリノイ大学アーバナ・シャンペーン校のベックマン先端科学技術研究所が協力しています。

Music Haptics

Music Hapticsは、iPhoneのTaptic Engineを使い、音楽プレーヤーアプリがオーディオに連動して「タップ、テクスチャ、細かな振動」を発し、聴覚障害を持つユーザーに新しい感覚をもたらす機能です。

Music Hapticsは Apple Musicの数百万曲の楽曲で機能するほか、APIを通じて他のアプリでも使えるようになります。

Vehicle Motion Cues

Vehicle Motion Cuesは、自動車で移動中に助手席や後席でiPhoneやiPadを使っている場合に、乗り物酔いを起こしにくくする機能。

具体的には、アプリ画面のうえから画面の周囲に小さなドットを表示して、乗りものによる揺れに合わせて動かすことで、目に対する揺れと静止物(つまり画面)を観る際の感覚のズレを調整し、酔いを起こしにくくすると説明しています。

そのほかの追加アクセシビリティ機能

今回の発表では、iPhoneやiPadの他にもいくつかの製品向けのアクセシビリティ改善機能がリストアップされています。

たとえば Vision Pro の visionOS には、対面の会話やアプリなどシステム全体で使えるライブキャプション機能が加わります。

これらの機能はおそらく、来月のWWDCで発表されるiOS 18およびiPadOS 18、その他OSアップデートに含まれると考えられますが、今回の発表ではいずれも「今年後半」に提供を開始するとだけ記されています。

ちなみに、アップルのウェブサイトにある「アクセシビリティ」のページには、すでに提供されているアクセシビリティ関連の機能が紹介されています。