Apple IntelligenceのLLMと直接対話したい。それは可能なのでしょうか?

開発者会議なのにヴァイブコーディング(Vibe Coding)のヴァの字も出なかったWWDC25ですが、サードパーティーアプリからOS内のApple IntelligenceオンデバイスLLM(大規模言語モデル)にAPIアクセスできるようになったのは朗報です。

しかしながら、Apple IntelligenceのオンデバイスLLMであるFoundation ModelにはXcodeを触れる開発者でないとにアクセスできません。30億パラメータ、2bitの量子化が行われており、OS搭載のLLMとしては大規模ではありますが、要約、抽出、分類などの特定のユースケースに最適化されており、世界知識や高度な推論を必要とするタスクには向いてないとの説明がされています。

それでもせっかく手元のマシンに搭載されているのですから、その人柄(性能)には触れておきたいもの。ただ、残念ながらXcodeを使わないとFoundation Modelとの対話はできません。

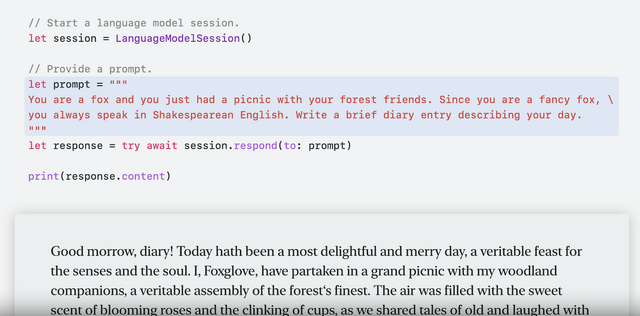

今のところの手がかりは、せいぜいWWDCのセッションで見せた、プロンプトに従って物語を紡げますよ、古代英語でも可能ですよ、というデモくらい。

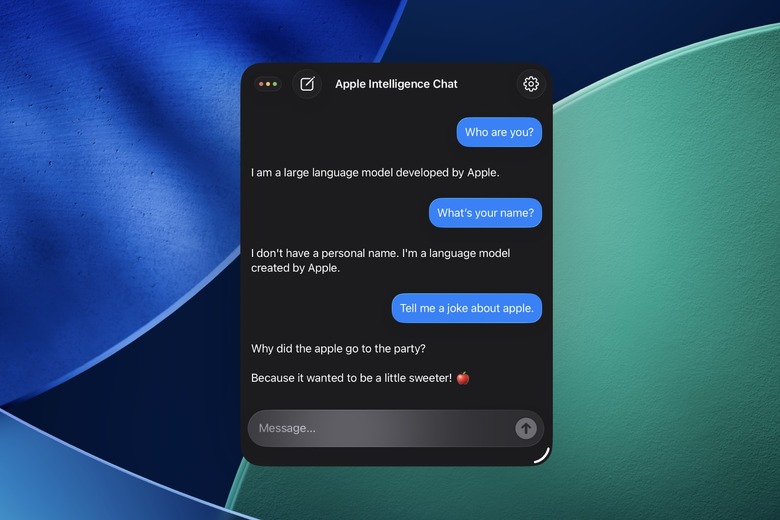

Apple Intelligence Chat

ところが、これを実現可能にしてくれるオープンソースプロジェクトが登場しました。MMLとのチャットアプリを開発しているPallav Agarwalさんの「Apple Intelligence Chat」(ストレートすぎるこの名前にはAppleからそのうちクレームが来ると思いますが)がそうです。

デベロッパー向けにベータ版が公開されたXcode 26でビルドすることで、iOS 26のシミュレータ上で、Apple Intelligenceのオンデバイス版Foundation Modelとの対話が可能になります。

やはり気になるのはその性能です。

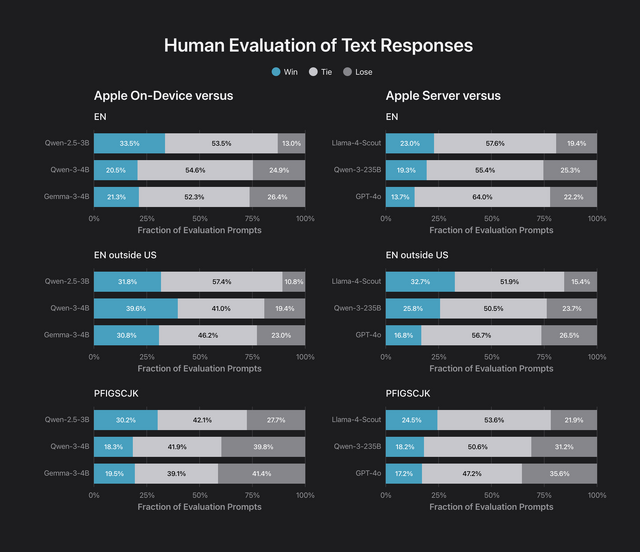

Appleによる性能評価はQwen-2.5-3B、Qwen 3-4B、Gemma 3-4Bとほぼ互角と出ていますが、これだけではなんとも。

サーバ版Foundation Model(Private Cloud Compute)のライバルは、ChatGPT-4o、Llama-4-Scout、Qwen-3-235Bということがわかります。ちなみに、235B版Qwen-3は512GB Unified Memory搭載のM3 Ultra Mac Studioで清水亮さんが動かしています。

Appleの次期OSや開発環境はNDAで縛られているために、このプロジェクトを動かした結果を公開することはできませんが、試したユーザーによれば、日本語の物語も一部英語に化けるところがあるものの、大きな破綻がないようで、J-POPの歌詞の生成も可能らしいです。

さすがに作曲はできないものの、J-POPの典型的なバラードのコード進行を考えるところまではいけてるという話。

この情報が確かならば、2023年あたりのChatGPTとさほど変わらない性能を持っていることになりますね。

Gemmaなどの軽量LLMをローカルで動かせるアプリはいくつも出ており、筆者も使っていますが、ロードに時間がかかるのと、ただでさえ圧迫され気味のストレージをかなり食ってしまいます。それに対してFoundation ModelはOSに組み込まれているため、それ以上のストレージ要求はありません。このくらいの性能があれば、けっこう使いではあるのではないでしょうか。

ネットから遮断された状態でも、無限に物語を作ってくれるはずです。バッテリーが持てば。

iOS 26などの新バージョンOSが正式公開になる秋頃まではこっそりお楽しみください。OSが正式版になったら、App Storeは類似アプリで埋まると思います。