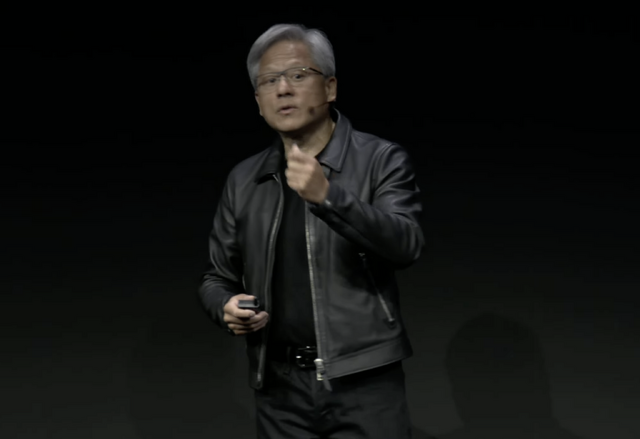

米ロサンジェルスで開催中のコンピュータグラフィックス国際会議SIGGRAPH 2023で8月8日、NVIDIAのジェンスン・ファンCEOが基調講演を行いました。新しいGPUアーキテクチャの発表こそなかったものの、いくつかの重要なアナウンスがありました。

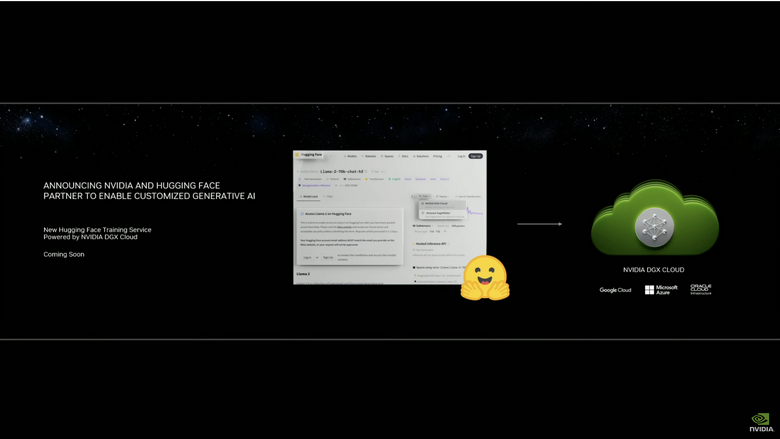

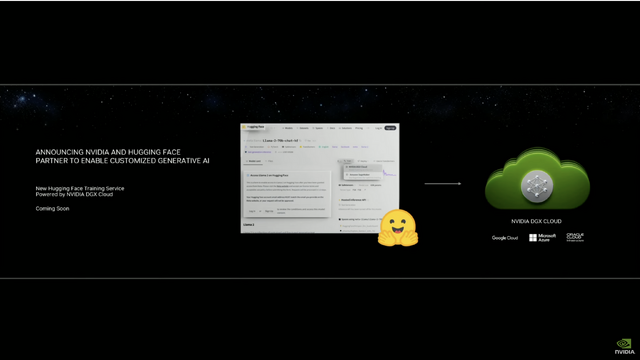

その一つが、Hugging Faceとの提携。

Hugging Faceといえば、画像生成AIから大規模言語モデル(LLM)まで、さまざまなAIモデルのリポジトリとして使われている、生成AIに関わっている人なら必ずお世話になっているサービスです。

NVIDIAはこの発表を、「NVIDIAとHuggung Faceはパートナーシップを結び、生成AIスーパーコンピューティングを数百万もの開発者に提供し、LLMをはじめとする先進のAIアプリケーション開発に資する」と説明しています。

具体的には、NVIDIAのクラウドAIスーパーコンピューティングサービスであるNVIDIA DGXをHugging Faceに提供し、Hugging Faceは「Training Cluster as a Service」(サービスとしてのトレーニングクラスター)を今後数カ月以内にスタートする予定となっています。

NVIDIA DGXのインスタンスはNVIDIA H100またはA100 80GB Tensor Core GPUで、1ノード当たり640GBのGPUメモリが使用可能。これにより、企業が特定業界、業種向けLLMの構築を行う場合、自社で構築しなくてもHugging Faceのサービスを使うことですぐに学習を始められるとしています。

「Hugging Faceの中から適切なモデルを探し、それをDGXクラウドを使ってファインチューンするといったことが手軽にできるようになる」とフアンCEOは基調講演で語っていました(開始1時間2分あたり)。

現時点では価格体系は公開されておらず、企業向けとしているところから個人の開発者が利用できるかどうかは不明ですが、まずGPUを購入することから始めなければならない企業や組織にとっては検討すべき選択肢と言えそうです。

なお、この基調講演を締めくくるファンCEOの言葉は「The more you buy, the more you save」。「(うちのGPUやサービスを)買えば買うほど節約になるよ」というものでした。

¥282,626

(価格・在庫状況は記事公開時点のものです)

¥187,879

(価格・在庫状況は記事公開時点のものです)