アップルは、日本時間6月10日午前2時から、世界開発者会議(WWDC25)の基調講演を配信しました。今回はハードウェアの話題はなかったものの、アップルの製品に搭載される各OSに対する、大幅なアップデートが発表されています。

最も大きな変更は、iPhoneからApple Watch、Macに至るまで、各OSが共通のデザイン要素であるLiquid Glassを採用したことが挙げられます。

これは名前の如く、水のようなガラスのような半透明のUIパーツで、アップルいわく「よりコンテンツへの注目を高める」効果を生み出し、「新たなレベルの活力をもたらす」ことを意図したデザインとなります。このような共通デザイン要素をすべてのOSに導入したのは、アップル「史上はじめて」のことだそうです。

そして、Liquid Glassのほかにもうひとつ、Apple製品全体にさらに浸透したのがApple Intelligenceです。

今回のWWDCでは「iPhone、iPad、Mac、Apple Watch、Apple Vision Proのユーザー体験を向上させる」とうたうApple Intelligenceの新機能として、ライブ翻訳機能、ビジュアルインテリジェンス機能、ジェン文字、Image Playgroundなどが追加または強化されます。

さらに、ショートカットからApple Intelligenceに直接アクセスしたり、開発者がアプリからApple Intelligenceの大規模言語モデルにアクセスしたりすることも可能になります。

ライブ翻訳機能は、メッセージアプリやFaceTime、電話でのやり取りの際に、言語の壁をなくしてコミュニケーションを取ることを可能にする機能です。たとえば、Messageアプリで自分が日本語、相手が英語しか使えないような場合に、いちいち相手からの英語メッセージを範囲指定して、コンテキストメニューから翻訳機能を選択せずとも、Apple Intelligenceがすぐに日本語の訳文を表示します。

FaceTimeのビデオ通話の場合は、話し手の声を聞くのとほぼ同時に、画面上に翻訳された文章が表示されます。また、電話による会話では、Apple Intelligenceが同時通訳よろしく、相手の話を翻訳して音声で読み上げるようになります。

他の人とのコミュニケーションに関連する機能としては、ジェン文字とImage PlaygroundもApple Intelligenceによって強化されました。ユーザーはテキストで記した説明文からジェン文字を生成したり、すでにある絵文字と説明文によって、双方の要素を組み合わせた新たなジェン文字を生み出すことができます。

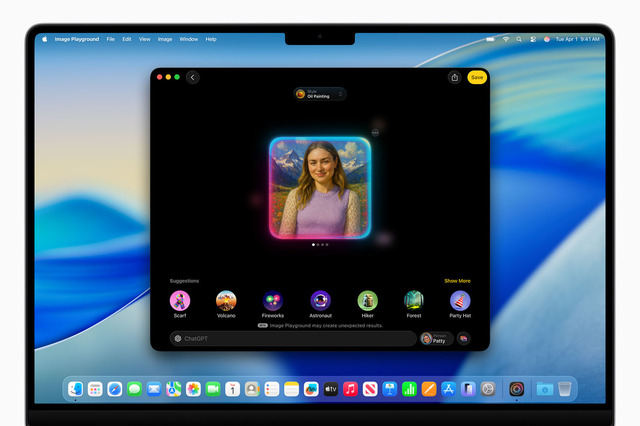

Image Playgroundでは家族や友人などの画像から、画風や外観などを指定して加工した画像を作り出すことが可能になります。また、オプション機能でChatGPTの画像生成機能を呼び出し「任意のスタイル」を作ることもできます。ちなみに、ChatGPTの利用に際しては、ユーザーが許可しない限り、いかなる情報も共有されないことをアップルは強調しています。

強化されたビジュアルインテリジェンス機能では、「Googleレンズ」のように画面上に表示されている写真から、そこに映っているものについて検索をしたり、ChatGPTに質問して詳しい情報を得たりすることが可能になりました。Googleアプリなど、対応するアプリを用いて、その画像にある物に似た画像や、商品をオンラインで検索することもできます。また、音楽ライブなどイベントのフライヤー画像をタップして、画像のなかの日付や開催地など関連する情報をカレンダーに追加するといった使い方もできます。

ショートカット機能では、Apple Intelligenceを利用した機能的なアクション が使えるようになります。たとえば、作文ツールによるテキストの要約、Image Playgroundによる画像の生成などに対応する専用のアクションなどが用意されるほか、授業や会議の録音データから起こしたテキストと、ユーザー自身が筆記したノートを比較させて、聞き落としていた部分を追記するショートカットなども作れます。

Apple Watchでは、Apple Intelligenceを利用する新機能としてWorkout Buddyが発表されました。Workout Buddyは心拍数、ペース、距離、アクティビティリング、個人のフィットネス目標達成度などのデータを分析し、Fitness+トレーナーの音声データとテキスト読み上げモデルの機能により生成した音声で、ワークアウトに合わせた熱量、スタイル、口調でユーザーを励まします。

今回発表されたApple Intelligence機能は、この秋にリリースされるiOS 26、watchOS 26、macOS 26、visionOS 26、iPadOS 26に搭載される予定です。なお、今回の発表では、開発者が独自のアプリからApple Intelligenceのデバイス上のAIモデルに直接アクセスすることが可能になることも発表されています。今年後半以降は、Apple Intelligenceを活用した個性的なアプリがいくつも出てくるかもしれません。

ただし、Apple Intelligenceを利用できるのは、iPhone 15 Proおよび15 Pro Max、iPhone 16全製品のほか、M1チップ以降を搭載するiPadまたはMacという要件があります。もし、手持ちのデバイスが対応していないけれどApple Intelligenceは使いたいと思ったなら、この秋が買い替えの良い機会かもしれません。