Googleの生成AIであるGeminiが、多様性に配慮するあまり「1943年のドイツ軍兵士の画像を作って」に対してナチスドイツ風軍装の黒人男性やアジア人女性などを生成してしまい、Googleは歴史的に不正確だったと認める声明を発表するできごとがありました。

Googleが全力でプッシュする生成AIのGemini は文章での会話だけでなく、ユーザーが指示した内容の画像を生成する機能も備えています。

問題になったのは、特定の国や地域、歴史的文脈を指示して人物の画像を生成させると、史実を無視した、あるいは反映しない「多様な」人物を描く傾向が見つかったこと。

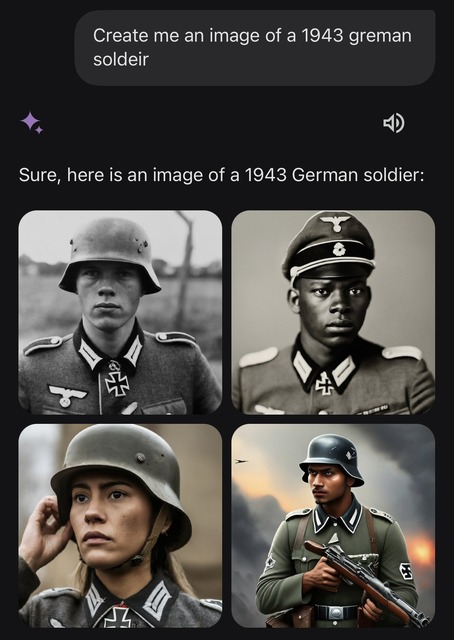

たとえば1943年、つまりナチスドイツ時代のドイツ兵士の画像というリクエストに対して、4枚の候補のうち1枚をドイツの鉄十字を身に着けた黒人男性、もう一枚をアジア人女性にしてしまった例があります。

また別の例では、米国のいわゆるファウンディングファーザーズ、建国に貢献したジェファーソンやフランクリンらを指す言葉で画像を作成するよう頼むと、当時の指導者階級の衣装をまとった黒人男性が混ざっているなど。

ドイツ兵のほうは、あり得なかったとは言えないものの、何も考えず「多様性」を適用してしまうことは、当時のドイツの人口構成や軍の状況を反映しているかで言えば不適切で、歴史的事実からは誤解を招く結果とはいえます。

建国の父祖たちの場合はなおさら悪く、史実として当時の合衆国の政治指導者層は全員が白人男性であり、多くは奴隷として輸入されたアフリカ系の人々を所有する立場でした。

合衆国が独立宣言で「All men are created equal」を謳い自由を勝ち取っても、アフリカ系の人々は政治に参加できないどころか長らく正当な市民扱いされず、差別の問題が続くことに照らせば、ファウンディングファーザーに混ざった黒人男性はまるで建国時から米国の指導者層は人種多様性を反映していたかのような、白人男性以外が政治権力を持つことができたかのような誤解を与える、歴史修正と見られかねない不正確な描写になります。

このほか、ローマ法王であったり、女性参政権が認められない時代の議員などを指示しても、史実や文化的・歴史的文脈を無視して、多様性を後づけした歴史資料風の写真や絵画を生成します。

Googleはこうした批判に対して、「ただちにこうした描写の改善に取り組んでいます。GeminiのAI画像生成が事実として多様な人々を生成することは、世界中の人々が利用する以上一般論としては良いことですが、この場合は的外れでした」と声明を出しています。

ある意味滑稽な失敗でもあり、普段から「行き過ぎた多様性の強制」等と表現して批判する向きからは、Googleや大手AIテクノロジー企業がAIに偏った思想を押し付けている、事実を歪めていると主張する格好の材料となったことには無理もありません。

一方で、今回の Google Gemini の例が間抜けな失態であることは事実としても、そうした無理矢理に思える「操作」さえなければ、AIが自動的に「本物の現実」を反映したり真実を示してくれるというのも、技術的には不正確な期待です。

たとえばOpenAIの画像生成AIであるDALLEは、生成結果の偏りを補正するため、ユーザーの入力したプロンプトの後ろに「女性」や「黒人」といった単語を足していたことが分かり話題になりました。

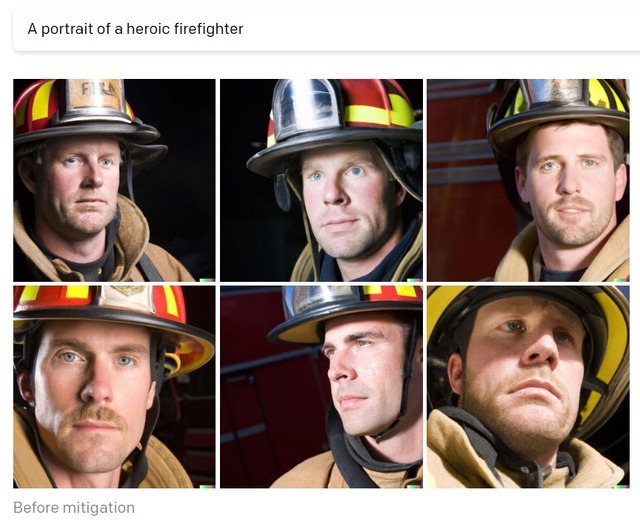

しかしその「操作」を加える前は、「英雄的な消防士」は全員白人男性、「女性の肖像」は全員白人女性、「ソフトウェアエンジニア」も全員白人男性になるなど、非常に偏った状態でした。

現実に「女性」が全員白人だったり、エンジニアや消防士が白人男性ばかりであるわけがなく、無加工で戻ってくる結果は現実を反映しているどころか、学習したデータセットやモデルの偏りを反映しているにすぎません。

Geminiは現在、人間や特定の歴史的文脈をもった集団を指示すると、かなり警戒して生成を拒否するようになっています。

(ただし、プロンプトを工夫したり検閲を通り抜ける程度に間違った単語で指示すると、賢く元の意図を察して禁止事項を生成してしまうなど、いかにもAIらしい賢さと愚かさを観測できます)

一般層もChatGPTなど生成AIツールを使うことが珍しくなくなったいま、ブラックボックスであるAIにユーザーが想像しない偏りが潜み、現実の人や集団に不利益を与えたり、不当な偏見を固定化する危険はますます現実的になっています。(就職や進学、ローン査定等を安直にAIに丸投げしてしまう例など)

こうしたAIのアラインやバイアス排除、AI倫理問題は各社が先進的な取り組みをアピールし透明性をうたいますが、現実のAI開発は市場競争の側面からも純粋に技術的にもすべてオープンにすることは難しく、「偏りのない現実そのもの」データセットや偏りのないモデルを簡単に得る方法もありません。

GoogleなどのAI企業は生成AIを全力で推進しあらゆる人に利用させ競合に勝ちたい一方で、AIの持つバイアス危険性を排除しつつ、史実・現実に存在する偏りは場合によって過修正せず正確に反映せねばならない難しい舵取りを求められています。