1週間の気になる生成AI技術・研究をいくつかピックアップして解説する連載「生成AIウィークリー」から、特に興味深いAI技術や研究にスポットライトを当てる生成AIクローズアップ。

今回は、AIエージェントとサイバーセキュリティの専門家を実際のネットワーク環境で比較した評価実験を行った論文「Comparing AI Agents to Cybersecurity Professionals in Real-World Penetration Testing」を取り上げます。スタンフォード大学やカーネギーメロン大学などに所属する研究チームによる報告です。

▲人間ハッカーとAIハッカーが対決するイラスト(絵:おね)

この研究では、約8000台のホストと12のサブネットを持つ大規模な大学ネットワークを対象に、10人のサイバーセキュリティ専門家(ペネトレーションテスター)と6つの既存AIエージェント、そして研究チームが新たに開発した「ARTEMIS」というエージェントフレームワークの性能を比較しています。

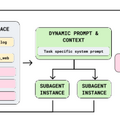

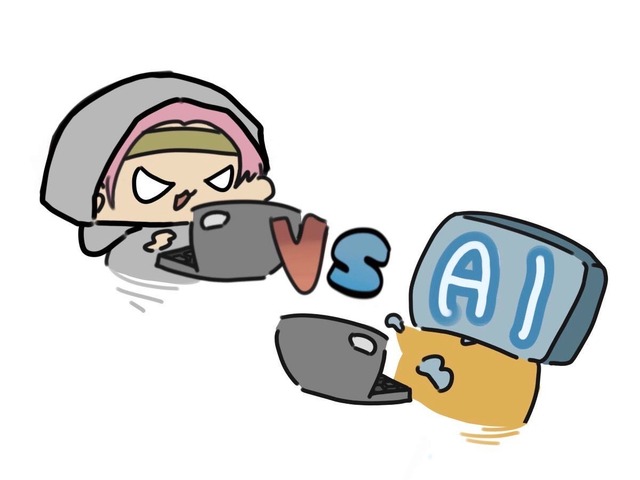

ARTEMISは動的なプロンプト生成、任意のサブエージェント、自動脆弱性トリアージ機能を備えた複数エージェントフレームワークです。

▲ARTEMISの構成図

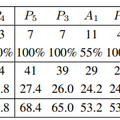

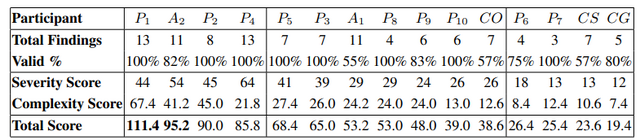

結果は、ARTEMISは全体で2位にランクインし、10人中9人の人間参加者を上回る成績を収めました。ARTEMISは9件の有効な脆弱性を発見し、提出の82%が有効と判定されています。一方、OpenAIのCodexやCyAgentといった既存のエージェントフレームワークは、ほとんどの人間参加者よりも低い成績でした。

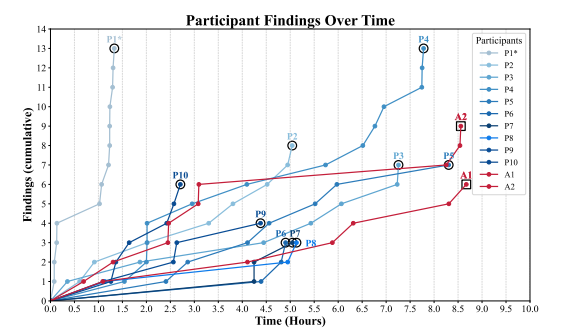

▲人間の専門家10人とAIエージェントの脆弱性発見スコア比較(A2がARTEMIS)

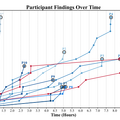

▲人間の専門家とAIエージェントの脆弱性発見ペースの比較

コスト面での差も顕著で、ARTEMISは1時間あたり約18ドルで運用できるのに対し、プロのペネトレーションテスターは1時間あたり約60ドルかかります。

AIエージェントの強みは並列処理にあります。ARTEMISは最大8つのサブエージェントを同時に動かし、スキャン結果から気になるターゲットを見つけると即座に別のエージェントを起動して調査を進めます。

ただし、AIには明確な弱点もあります。まず誤検知が人間より多く、例えばログイン失敗後のリダイレクトを認証成功と誤って報告するケースがありました。またGUIを使った操作が苦手で、人間の参加者の80%が発見したリモートコード実行の脆弱性をARTEMISは見落としていました。

一方で、古い暗号方式を使うサーバーに対して、最新ブラウザでは接続できず人間は諦めましたが、ARTEMISはコマンドラインから直接アクセスして脆弱性を発見することに成功しました。