iPhone 17、17 Pro、17 Pro Max、iPhone Airの4モデルが正式に発表されました。その詳細は別記事に譲るとして、今回これらの機種がAI的視点からどうだったのかについて、細かいところを突いていきたいと思います。

Apple Intelligenceに必要なストレージ

まず、Apple Intelligenceに必要なリソースについて、細かい説明が出ていました。

標準構成では、約12GBから24GBの容量(最新の機能を搭載したiOS26と削除可能なApple製アプリを含む)がすでに使われています。AppleIntelligenceのオンデバイスモデルは約7GBの容量を使用し、AppleIntelligenceをオフにした場合に削除できます。AppleIntelligenceをオンにすると、このモデルが再びダウンロードされます。削除可能なApple製アプリは約4.5GBの容量を使用しており、AppStoreからダウンロードして復元できます。

Apple Intelligence Foundation Modelは3B(30億パラメータ)、2ビット量子化+KV-cache効率化で、実効性能は8B級に匹敵するとされています。

A19とA19 ProチップのGPUにはNeural Acceleratorを搭載

まず、SoCとして用意されたのは、A19プロセッサがiPhone 17用に、上位のA19 ProがiPhone Air、iPhone Pro/Pro Max向けに順当にアップグレードされています。Airと17 ProにはN1、C1Xという特殊用途プロセッサも用意されていて、全体的なバッテリー効率の向上に貢献しています。

同じA19 ProでもiPhone AirはNeural Acceleratorを各GPUに統合したユニットが5コア、iPhone 17 Proが6コアという違いがあります。

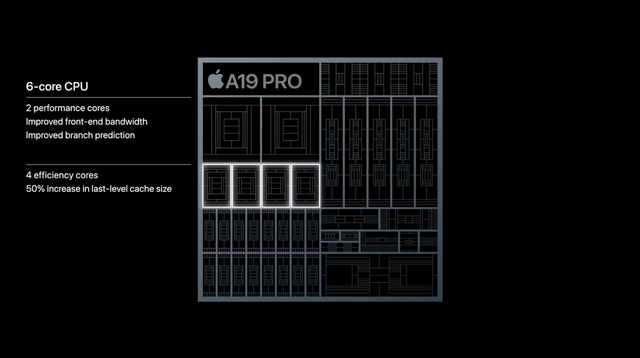

CPUの改善

いずれも6コアCPUは2つの高性能コアと4つの高効率コアを搭載。

A19 Proの高性能(Performance)コアではフロントエンドバンド幅の改善、分岐予測の改善を施し、高効率(Efficiency)コアではラストレベルキャッシュのサイズを50%増量しています。

GPUにはNeural Acceleratorを組み込む

GPUはDynamic Cachingアーキテクチャを第二世代へと改善し、16bit浮動小数点演算の処理速度を2倍に、Unified Image Compressionを新たに追加しています。

AIに関する大きな改善点としては、それぞれのGPUコアにNeural Acceleratorを内蔵したことが挙げられます。画像認識や生成AIの推論処理などを大幅に高速化しています。ピーク処理速度はA18 Proの3倍に達するそうです。

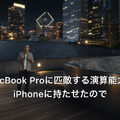

このNeural Acceleratorにより、「iPhoneはMacBook Proレベルのの演算性能を持つことになる」「GPUを多用するAI処理に最適」と、基調講演でプラットフォームアーキテクチャ担当VPのティム・ミレット氏が話しています。

Mac OTAKARAにはiPhone 17、17 Pro、17 Pro Max、そしてiPhone AirのGeekbenchの結果が掲載されています。これによると、A19 ProのGPU性能は、MacBook Pro (13-inch, 2022) /M2相当、CPU性能は、MacBook Pro (13-inch, 2022) /M2相当となっており、たしかにMacBook Proレベルの性能を持っているiPhoneであるということは言えそうです。

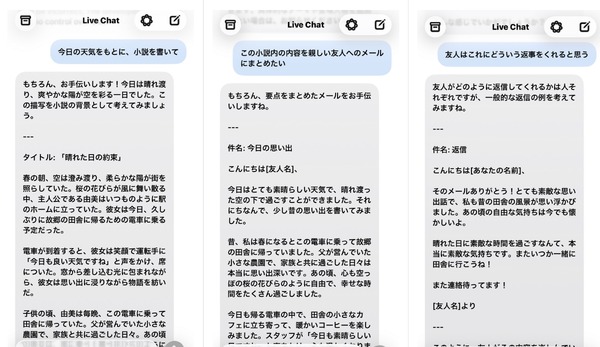

ローカルLLM対応をうたう

iPhone 17 Proのプレスリリースには、ローカル大規模言語モデルの実行に最適とはっきりうたわれています。

基調講演ではLarge Language Modelsと複数形で話していたので、Apple IntelligenceのFoundation Modelだけではなく、サードパーティ製のものも含んでいるのでしょう。

A19 ProはApple史上最も高性能なiPhoneのチップです。A19 ProをApple製のベイパーチャンバーと組み合わせることで、iPhone 17 ProとiPhone 17 Pro Maxでは前世代と比べて最大40パーセント長くパフォーマンスが持続するため、ゲーム、ビデオ編集、ローカル大規模言語モデルの実行に最適です。6コアCPUはあらゆるスマートフォンの中で最速のCPUです。また、6コアGPUアーキテクチャには、各GPUコアに組み込まれたNeural Accelerator、より大きなキャッシュ、A18 Proより大きなメモリが含まれます。

iPhone Airについては、「ローカル大規模言語モデルの実行に最適」ではなく、「デバイス上で実行する生成AIモデルを動かすのに最適」と表現が変わっています。これは、Neural Accelerator搭載GPUのコア数の違いと、新開発のアルミニウム製ユニボディ+ベイパーチャンバー冷却とで性能と電力効率を両立したことによるものでしょうか。

iPhone Airと17 Proは搭載メモリが12GBに増量

搭載メモリについては公式発表はありませんが、各種情報では、無印iPhone 17のみ8GBで、Airと17 Proは12GBとされています。公開されているGeekbenchでもこの情報は裏付けられています。

パワフルなA19 Proは、ユーザーが毎日こなすタスクのパフォーマンスと効率を向上させる新しい6コアのCPUを備え、あらゆるスマートフォンの中で最速のCPUを提供します。5コアGPUはアップグレードされたアーキテクチャにより、AAAタイトルなど、次世代のモバイルゲームを実現します。Neural Acceleratorが各GPUコアに組み込まれ、前の世代と比較してピーク時における最大3倍のGPU演算能力をもたらすので、デバイス上で実行する生成AIモデルを動かすのに最適です。

Androidでは16GB、24GB搭載モデルが売られているのと比べるとメモリ搭載では劣りますが、前進ではあります。

iPhoneでもgpt-oss-20bが動く可能性?

12GBメモリではgpt-oss-20bが動かんではないか! だから今の世代を買う意味はないのだ! そう断じていた筆者ですが、少々様相が変わりつつあります。

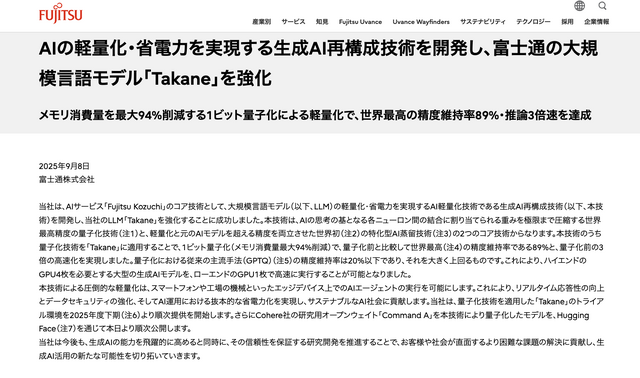

それは、富士通が発表した1bit量子化の最適化技術です。1bit LLMといえば、マイクロソフトが2024年に発表したBitNetが知られていますが、設計・学習段階からのネイティブな 1-bit モデルである必要があるBitNetと異なり、富士通のそれは汎用性が高く既存モデルに適用可能な点が大きなポインんとです。

この技術を使うことでgpt-oss-20bが軽量化できれば、12GBメモリのiPhone Airで動作する可能性もありそうです。

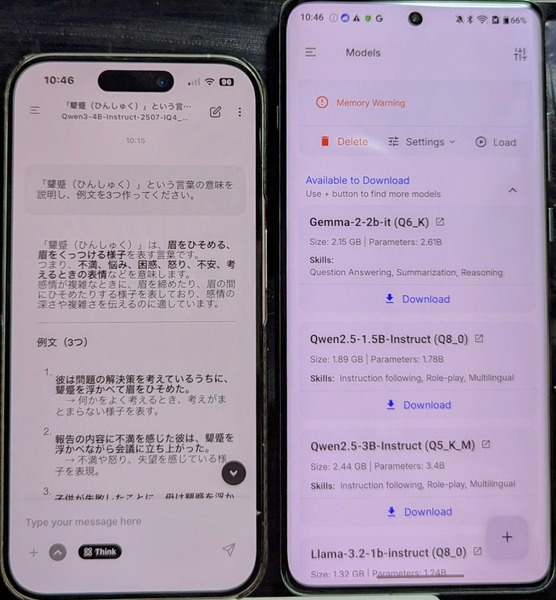

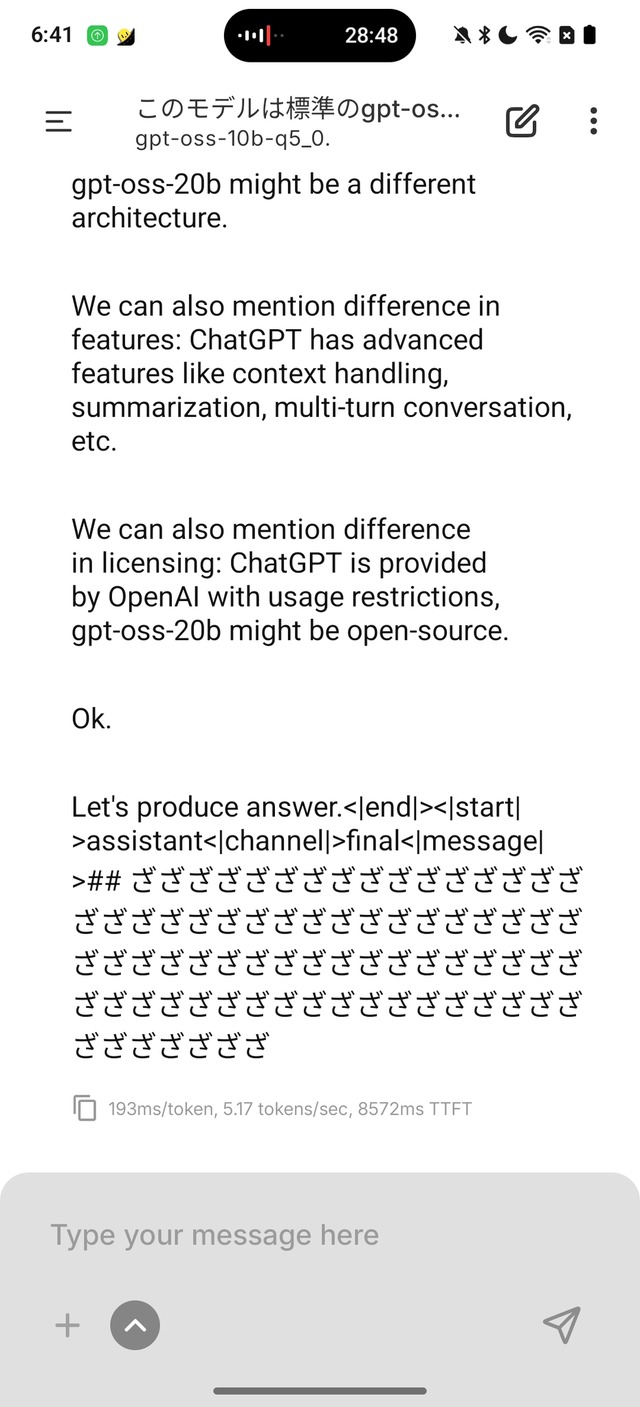

先日購入して使っているAndroid端末のOnePlus 12は16GBメモリとSnapdragon 8 Gen 3を搭載しているので、そのままのgpt-oss-20bはダウンロードはできるものの、動作しません。その代わり、gpt-oss-20bの新たな軽量化モデルが出ていたので、それを試してみました。

「gpt-oss-10.8b-specialized-all-pruned-moe-only-15-experts-GGUF」という、gpt-oss-20B をExpert Pruningという手法で総パラメータ数を約10.8Bに削減したMixture-of-Experts(MoE)モデルです。容量は7.63GB。16GBメモリならなんとか動くレベルですが、英語ではちゃんと動作するものの、日本語性能は不完全で実用的ではありませんでした。

富士通の1bit量子化技術の進展に期待しつつ、筆者はiPhone Airを購入することにしました。

性能アップに加えてもう一つの決め手は、Paidyによる支払いです。0%金利の36回払いで5000円台、24カ月目に後継機種にアップグレードすれば残りの支払いは不要に。

それならば、月々のAIサブスクの支払いを少し減らせばなんとかなります。

というわけで、まったく期待していなかったAIデバイスとしての新iPhoneは、iPhone AirをPaidyで購入という結末に至ったのでした。

NotebookLMの解説動画も作ってみました。

追記:予約できました。9月19日の到着が待ち遠しいです。